开源 AI 项目 Jan 团队近日震撼发布全新多模态大模型 Jan-v2-VL-Max,这款拥有 30B 参数的先进模型,摒弃了盲目追求通用性的传统路径,而是精准聚焦于“长周期执行任务”这一长期困扰 AI 领域的核心痛点。Jan-v2-VL-Max 的诞生,正是为了攻克 AI 在复杂自动化流程中容易出现“任务中断”或“逻辑脱节”的难题,为 AI 的稳定运行注入强大动力。

该模型的技术架构深植于 Qwen3-VL-30B-A3B-Thinking 的坚实基础上,并在此基础上进行了创新性的优化。为了显著提升多步操作中的执行稳定性,Jan 团队独具匠心地将 LoRA-based RLVR 技术融入模型设计。这项技术的核心优势在于能够有效遏制多步执行过程中的误差累积效应,从而大幅降低 AI 在处理长任务时产生“幻觉”或“记忆模糊”现象的概率。通过这一创新,Jan-v2-VL-Max 在保持强大多模态处理能力的同时,实现了逻辑连贯性的飞跃。

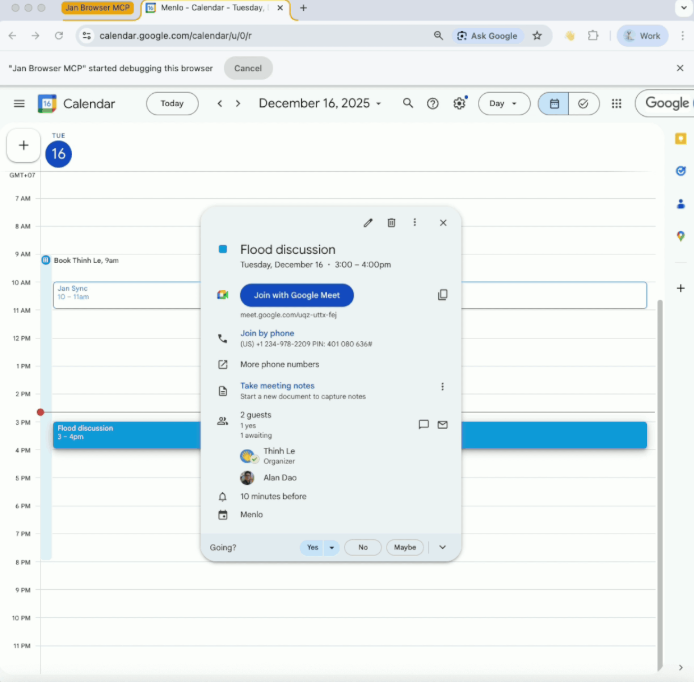

在权威的“幻象递减回报”基准测试中,Jan-v2-VL-Max 的表现堪称惊艳,其执行稳定性超越了包括 Gemini2.5Pro 和 DeepSeek R1 在内的多款业界领先模型。这一卓越成绩充分证明,Jan-v2-VL-Max 在处理 Agent 自动化、UI 界面智能控制以及其他对逻辑连贯性要求极高的复杂任务时,展现出无与伦比的可靠性和高效性。无论是需要精确指令链的自动化流程,还是要求高度交互连贯的智能界面,Jan-v2-VL-Max 都能提供稳定而强大的支持。

目前,Jan-v2-VL-Max 已经向开发者和 AI 爱好者全面开放。用户可以通过便捷的网页端直接体验模型的强大功能,也可以利用 vLLM 工具在本地环境中进行私有化部署。作为 Jan 生态中主打离线运行、严格保护用户隐私的重要成员,新模型的推出为那些追求本地化 AI 自动化解决方案的用户提供了更为强大和灵活的选择。这一举措不仅拓展了 Jan 生态的应用场景,也为 AI 技术的落地应用开辟了新的可能性。

huggingface:https://huggingface.co/janhq/Jan-v2-VL-max-FP8