多模态信息检索的边界正在被彻底重构,当图文、视频、图表乃至UI界面都能被统一”理解”并精准匹配时,一场深刻的变革正在悄然发生。阿里通义实验室今日正式开源两大革命性模型——Qwen3-VL-Embedding与Qwen3-VL-Reranker,它们基于强大的Qwen3-VL多模态基座构建,专为跨模态理解与高效检索而生,将多模态搜索从传统的”关键词匹配”时代强势推进至”语义对齐”的新纪元。

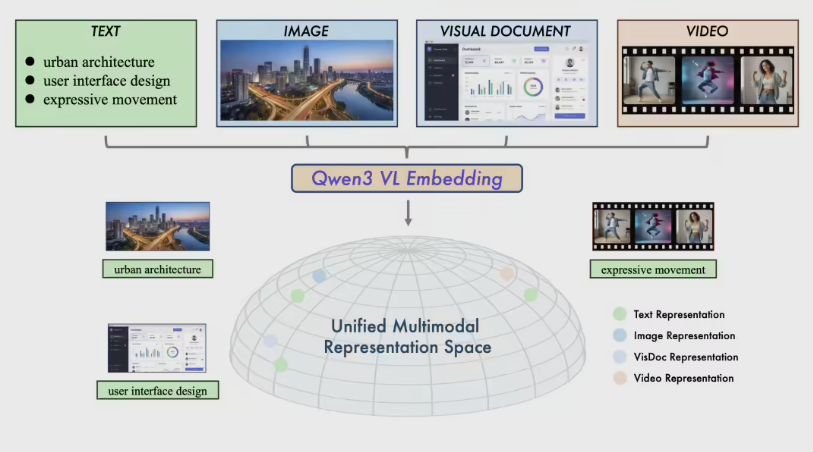

这两款模型并非孤立存在,而是构成了一套协同作战的智能检索引擎。Qwen3-VL-Embedding采用创新的双塔架构,能够将文本、图像、可视化文档(如代码截图、数据图表、App界面)乃至视频等异构内容,独立编码为统一高维语义空间中的向量表示。这意味着无论用户输入是一段文字描述、一张产品图,还是一段短视频,系统都能将其映射到同一语义坐标系中,实现毫秒级的跨模态相似度计算与海量数据召回。

而Qwen3-VL-Reranker则扮演着”精修大师”的角色。它采用单塔交叉注意力架构,对Embedding初步召回的结果进行深度重排序。当面对”图文查询匹配图文文档”或”视频片段检索相关文章”等复杂任务时,Reranker会将查询与候选文档联合编码,通过模型内部的交叉注意力机制,逐层剖析二者在语义、细节甚至上下文逻辑上的深层关联,最终输出一个精确的相关性分数。这种”Embedding快速召回+Reranker精细排序”的两阶段流程,显著提升了最终检索结果的准确率与相关性。

技术实力最终由数据说话。在MMEB-v2和MMTEB等权威多模态基准测试中,Qwen3-VL系列表现亮眼。其8B版本的Embedding模型在MMEB-v2上超越了所有已知的开源模型及主流闭源商业服务;Reranker模型则在包括JinaVDR、ViDoRe v3在内的视觉文档检索任务中持续领先,8B版本在多数子项中拔得头筹。尤为难得的是,该系列继承了Qwen3-VL的多语言基因,支持超过30种语言,且提供灵活的向量维度选择、指令微调能力以及高性能量化版本,极大降低了开发者集成门槛。

此次开源不仅是技术成果的释放,更标志着多模态AI基础设施的成熟。过去,图文检索、视频理解、文档分析往往需要各自独立的模型和流程;如今,Qwen3-VL双子星提供了一个统一、高效且开源的解决方案,让开发者能够在一个框架内处理几乎所有混合模态内容。随着真实世界的数据日益以多模态形式涌现,这套工具或将加速推动搜索引擎、内容平台、企业知识库乃至智能助理的下一代进化——在那里,机器真正”看懂”并”理解”我们所见、所写、所拍的一切。项目地址:https://github.com/QwenLM/Qwen3-VL-Embedding