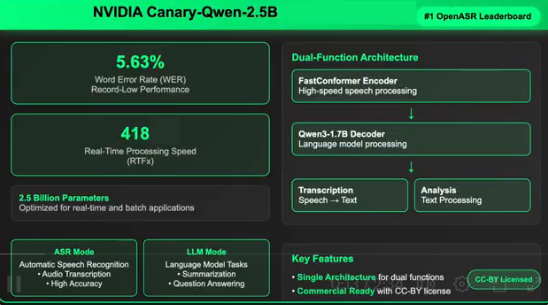

NVIDIA重磅推出Canary-Qwen-2.5B模型,这一突破性创新融合了自动语音识别(ASR)与大型语言模型(LLM)技术,以惊人的5.63%词错率(WER)强势登顶Hugging Face OpenASR排行榜榜首。该模型采用CC-BY许可协议,兼具商业授权与开源特性,为企业级语音AI发展扫清了重重障碍。

技术突破:统一语音理解与语言处理

此次发布标志着语音AI领域的重要里程碑,Canary-Qwen-2.5B创新性地将转录与语言理解整合至单一模型架构中,支持直接从音频数据执行摘要生成、问答等复杂下游任务。这种革命性架构彻底颠覆了传统ASR流程,将转录与后处理环节从独立阶段无缝整合为统一工作流程,大幅提升效率与准确性。

关键性能指标:全方位性能突破

该模型在多个核心维度创下历史新纪录:

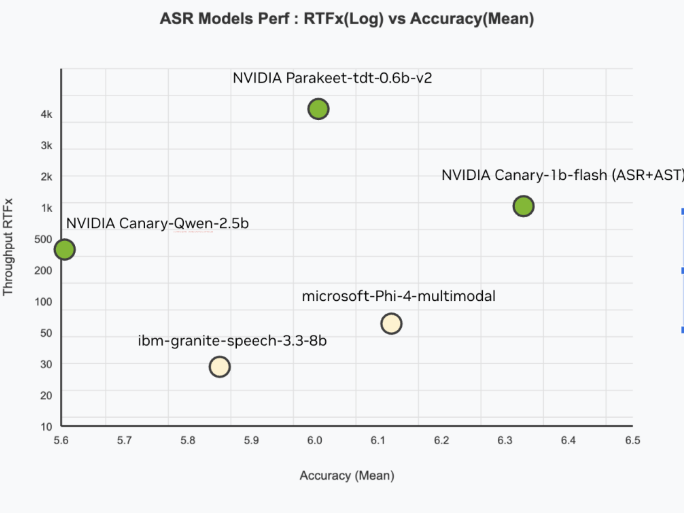

– 准确性:5.63% WER,刷新Hugging Face OpenASR排行榜最低纪录

– 速度:RTFx性能达418倍实时速度,远超行业平均水平

– 处理效率:仅含25亿参数,相比同类大型模型更为轻量化

– 训练规模:基于234,000小时多样化英语语音数据集精心训练

创新混合架构设计:双核驱动系统

Canary-Qwen-2.5B的核心创新在于其混合架构设计,包含两大关键组件:

– FastConformer编码器:专为低延迟、高精度语音转录而设计

– Qwen3-1.7B LLM解码器:未经修改的预训练大型语言模型,通过适配器接收音频转录标记

这种适配器设计实现了模块化,既允许Canary编码器独立运行,又能将Qwen3-1.7B作为独立LLM处理基于文本的任务。单一部署即可同时处理口语与书面输入的各类语言任务,极大提升多模态应用灵活性。

企业级应用价值:商业级许可赋能

与许多受非商业许可限制的研究模型不同,Canary-Qwen-2.5B采用CC-BY许可发布,为商业应用场景打开大门:

– 企业级转录服务

– 基于音频的知识提取系统

– 实时会议智能总结

– 语音控制的AI代理

– 符合法规要求的文档处理(医疗、法律、金融领域)

该模型的LLM感知解码功能显著提升了标点符号、大写字母和上下文理解的准确度,这些正是传统ASR系统长期存在的薄弱环节。

硬件兼容性与部署灵活性:全场景适配

Canary-Qwen-2.5B针对多种NVIDIA GPU进行了深度优化,从数据中心级的A100、H100,到工作站RTX PRO6000,乃至消费级GeForce RTX5090等全系列硬件均支持高效运行。这种跨硬件类别的广泛兼容性使其完美适配云推理与边缘计算环境。

开源推动行业发展:社区共创生态

NVIDIA研究团队通过开源Canary-Qwen-2.5B模型及其完整训练方案,旨在加速社区驱动的语音AI技术进步。开发者可自由组合其他兼容NeMo的编码器与LLM,为特定领域或语言创建定制化混合模型。这一版本更开创了以LLM为核心的ASR新范式,将LLM从传统后处理器转变为语音转文本流程中的核心智能代理。

这种创新方法反映了AI发展向代理模型演进的大趋势——构建能够基于多模态现实输入进行全面理解与决策的系统。NVIDIA的Canary-Qwen-2.5B不仅是一个高性能ASR模型,更是融合语音理解与通用语言模型的典范之作。凭借顶尖性能、商业可用性及开放创新路径,该模型有望成为企业、开发者和研究人员开发下一代语音优先AI应用的重要基础工具。

https://huggingface.co/nvidia/canary-qwen-2.5b