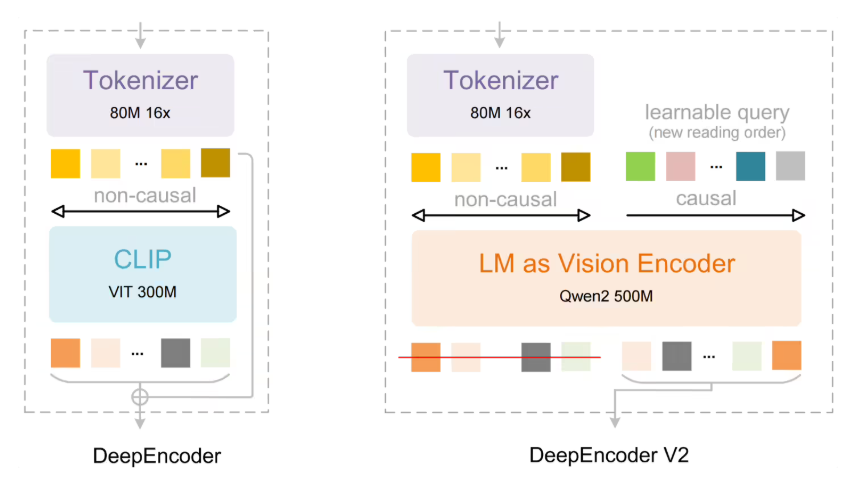

DeepSeek 隆重推出全新一代文档识别模型——DeepSeek-OCR2,为复杂版式文档的处理带来了革命性突破。该模型在视觉编码器设计上实现了重大创新,有效解决了传统模型在识别逻辑性方面的不足。DeepSeek-OCR2 的核心亮点在于自主研发的 DeepEncoder V2 编码器,这一创新技术彻底改变了传统视觉模型按照固定栅格顺序处理图像的方式。新模型引入了”视觉因果流”概念,能够根据图像语义动态调整信息处理顺序,在识别文字前先对视觉内容进行智能排序,从而使机器的阅读逻辑更贴合人类对表格、公式及复杂文档的理解方式。在架构设计上,DeepSeek-OCR2 沿用了高效的编解码框架。图像经过 DeepEncoder V2 进行语义建模和顺序重组后,将交由混合专家架构(MoE)语言模型进行解码,这一组合确保了模型在保持高性能的同时兼顾了计算效率。实验数据显示,在 OmniDocBench v1.5 基准测试中,DeepSeek-OCR2 的整体得分达到了惊人的 91.09%,较前代模型提升了 3.73%。特别是在阅读顺序准确度方面,其编辑距离显著降低,充分表明模型对内容结构的还原能力大幅增强。此外,DeepSeek-OCR2 在实际应用中也展现出卓越的稳定性。在 PDF 批处理及在线日志数据的测试中,识别重复率均有明显下降,这意味着模型在保持低资源开销的同时,提供了更高质量、更具逻辑性的识别输出。划重点:动态语义排序:DeepSeek-OCR2 通过”视觉因果流”技术,打破了传统固定栅格的识别顺序,实现了基于语义的动态阅读。性能跨越式提升:在权威基准测试中,新模型识别性能提升 3.73%,阅读顺序准确度显著增强。高效 MoE 架构:模型继续采用 MoE 架构解码,在不增加算力负担的前提下,实现了更高的识别精度与可靠性。