谷歌近期为其 Gemini2.5AI 模型推出了一项突破性的创新功能——”对话式图像分割”,这一技术让用户能够通过自然语言指令直接对图像进行深度分析和内容提取。与传统的图像分割技术相比,该功能实现了质的飞跃,赋予AI模型理解并响应更复杂、更具语义的指令的能力,彻底改变了人机交互的边界。

这项技术超越了传统图像分割的局限,不再局限于识别”狗”、”汽车”或”椅子”等固定类别的物体,而是能够理解并应用于图像特定部分的更复杂语言表达。Gemini 模型展现出惊人的智能水平,可以处理多种类型的指令需求:

首先,它能够理解关系查询,例如”撑伞的人”,通过分析图像中元素之间的逻辑关系来定位目标。其次,它支持基于逻辑的指令,如”所有非坐着的人”,展现出强大的推理能力。更令人惊叹的是,它还能识别抽象概念,例如”杂物”或”损坏”等没有清晰视觉轮廓的事物,这些概念在传统图像识别中一直是个难题。此外,得益于内置的文本识别功能,Gemini 还能识别需要阅读屏幕文本的图像元素,例如展示柜中的”开心果果仁蜜饯”,实现了视觉与语义的双重理解。

该功能支持多语言提示,用户可以用自己熟悉的语言进行操作,并且系统还可以按需提供其他语言的物体标签,极大地提升了全球用户的可用性。

这项创新技术在多个领域展现出广泛的实际应用价值,为各行各业带来了革命性的变化:

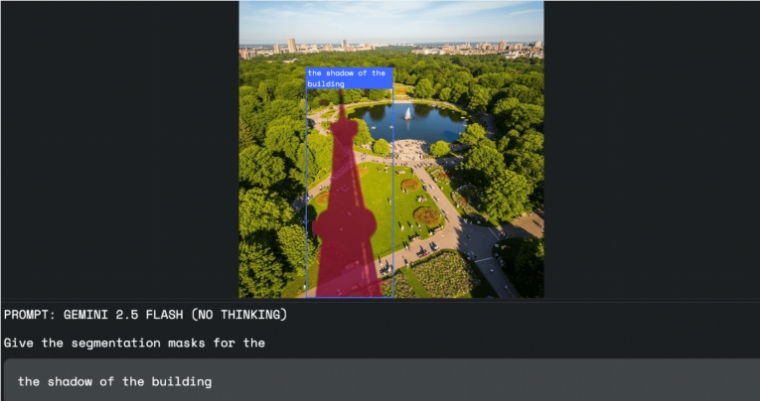

在图像编辑领域,设计师无需借助鼠标或选择工具,只需通过口头指令,如”选择建筑物的阴影”,即可精准选中所需区域,极大地提高了工作效率和创作自由度。在工作场所安全方面,Gemini 可以自动扫描照片或视频,精准识别违规行为,例如”施工现场所有未戴头盔的人”,为安全管理提供了强大的技术支持。在保险行业,理赔员可以通过”突出显示所有遭受风暴破坏的房屋”等命令,自动在航拍图像中标记受损建筑,大幅节省了手动检查时间,提高了理赔效率。

对于开发者而言,这项强大的功能无需特殊的独立模型,可以直接通过 Gemini API 访问”对话式图像分割”功能。所有请求均由具备此功能的 Gemini 模型直接处理,返回的结果以 JSON 格式呈现,包含所选图像区域的坐标(box_2d)、像素掩码(mask)和描述性标签(label),为后续开发提供了极大的便利。谷歌建议使用 gemini-2.5-flash 模型,并将 thinkingBudget 参数设置为零以触发即时响应,获得最佳效果。开发者可以通过 Google AI Studio 或 Python Colab 进行初步测试,快速将这一强大功能集成到自己的应用中。