还在为选择哪个AI模型而烦恼不已?面对琳琅满目的国内外大模型,选型耗时、信息分散、参数对比困难,是否让你感到效率低下?一个专注于“快选型”的AI模型库,或许正是你需要的导航利器。在AI应用开发或研究的前沿,选择一个合适的模型进行调用,往往是项目成功的第一步。然而现实情况是:模型爆炸式增长,国内外新模型、新版本发布速度惊人,GPT、Claude、通义千问、文心一言、Gemini、Llama…名单每天都在变长;信息碎片化,模型能力、调用价格、响应速度、支持上下文长度、接口状态等关键信息散落在不同平台、文档和社区讨论中,搜集耗时费力;对比维度复杂,除了基本的文本生成,还需考虑多模态支持、函数调用、微调能力、价格策略、区域可用性等多个维度,手动对比效率极低。结果就是:宝贵的开发或研究时间,被大量消耗在“模型选型”这个初始环节上。面对琳琅满目的选项,开发者、产品经理、研究者很容易陷入“挑花眼”的困境。

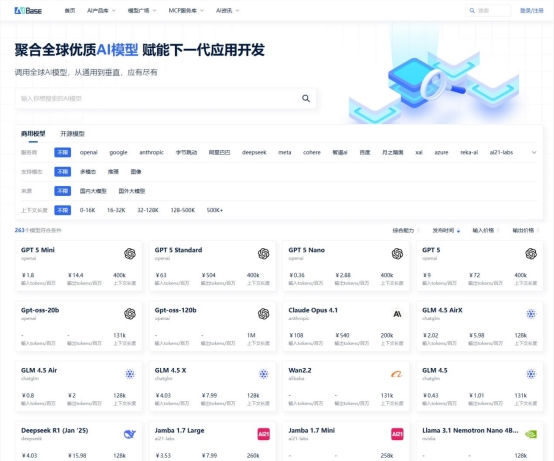

一、选型提速的关键:一个动态、多维的AI模型库如何破局?核心在于“快”——快速获取信息、快速对比分析、快速决策。这正是AIbase模型库(https://model.aibase.cn/llm)致力解决的痛点。我们将其定位为一个“AI模型选型加速器”。

二、AIbase模型库如何让你“快”起来?全球AI模型更新太快,今天这个模型开放了新功能,明天那个模型下调了调用价格。模型库会及时更新这些动态,你不用再刷遍技术社区找资讯 —— 打开页面,就能看到“近期值得关注的模型迭代”“价格调整通知”,1.一站式聚合,信息获取快:覆盖主流模型,库内整合了国内外主流、活跃的AI模型调用信息,省去你四处搜索的麻烦。关键指标直达,模型的核心能力、定价(按Token/次数等)、上下文长度限制、最新更新时间、官方链接等关键信息一目了然。状态实时追踪,关注模型接口状态更新,减少因服务不可用导致的试错成本。

2.多维度横向对比,决策快:结构化表格呈现,清晰直观的表格布局,让你一眼扫过多个模型的各项参数。自定义筛选聚焦,支持的上下文长度(能处理多少字的文本)、响应速度(生成一段内容要等多久)、多语言支持情况;调用成本:按token计费还是按次数计费,输入输出是否分开收费,批量调用有没有优惠;适用场景:是适合写文案、做数据分析,还是辅助代码开发?比如你想找“能处理5万字合同的模型”,直接按“上下文长度”筛选,就能快速缩小范围;再对比“调用成本”和“法律领域适配性”,几分钟就能锁定目标。综合参数对比,不再需要打开十几个标签页来回切换,在同一页面即可完成核心参数(如价格、上下文、速度基准等)的横向PK。

3.资讯更新同步,跟进快:新模型速递,关注全球AI模型动态,新模型上线或重要更新信息会及时纳入库中或通过平台更新告知用户。参数变更通知,当主流模型的关键参数(如价格、上下文长度)发生变动时,库内信息力求同步更新,让你始终知道“现在用哪个模型更划算”。

结果导向:省下的时间,用在刀刃上

三、AIbase模型库价值对于开发者:节省前期调研时间,更快锁定符合项目需求和预算的模型,加速集成开发流程。对于产品经理:快速评估不同模型的能力边界和成本,为产品功能设计和技术选型提供数据支撑。对于研究者:便捷了解业界模型生态和最新进展,辅助研究方向的决策。AIbase模型库的价值,不在于替代你的最终判断,而在于极大压缩你“做判断”前的信息搜集和初步筛选过程。它让你从信息的海洋中高效浮出水面,将精力集中在更有价值的应用构建、创新探索或深度研究上。

在AI技术日新月异的今天,“快”就是竞争力。与其在众多模型选项中迷失方向,不如利用专业工具提升效率。AIbase模型库将持续优化更新,致力于成为你调用全球AI模型时,最快速、最可靠的选型起点和资讯参考。访问https://model.aibase.cn/llm,开启你的高效模型选型之旅,让“挑花眼”成为过去式。