在众多大模型API中,开发团队如何突破选择困境?一份基于客观数据的深度对比分析,将为你提供清晰的决策路径。对于AI应用开发者和技术决策者而言,2024年既是机遇无限的时代,也是充满挑战的迷茫期。闭源大模型的选择从未如此丰富,但性能与成本之间的平衡却愈发复杂。一个看似高性价比的模型,可能在实际业务中因能力不足导致重试率激增;而一个功能强大的模型,又可能因价格高昂让初创企业望而却步。面对这种两难局面,精细化模型选型已从可选项升级为必修课。

01 模型选型困境:开发者面临的双重挑战

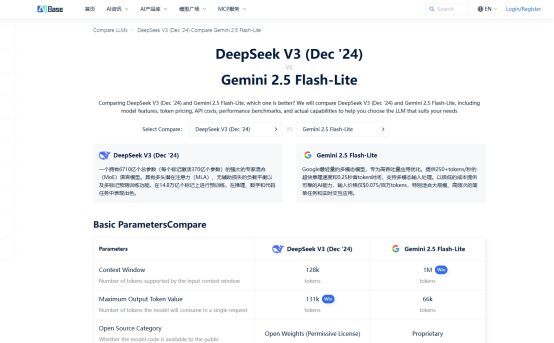

当前技术团队在选择大模型时主要遭遇两大难题:信息不对称和决策维度单一。多数开发者依赖厂商宣传资料或零散的社区评测,缺乏权威、中立的一站式对比平台。同时,许多人过度关注模型参数规模或单一指标,忽视了成本效益、上下文长度、场景适配性等关键要素。这种片面选型方式往往导致实际效果不达预期,或项目预算迅速超支。在此背景下,像AIbase模型选型对比平台(model.aibase.cn/compare)这样的工具应运而生,为开发者提供数据支撑的决策依据。

02 核心性能对比:多维能力全面解析

基于AIbase平台的客观数据,我们对Gemini 2.5 Flash-Lite和DeepSeek-V3进行了全方位对比。在综合能力方面,两个模型各具特色。Gemini 2.5 Flash-Lite在多语言理解和通用推理任务上表现突出,综合评分较高,适合处理多样化任务的综合型应用。DeepSeek-V3则在代码生成和逻辑推理方面优势明显,相关专项评测得分领先,特别适合开发者工具、自动化编程助手等场景。在数学能力方面,两者表现接近,都能胜任数值计算和公式推理任务。这种能力差异直接影响模型在不同场景的适用性。

03 价格体系分析:实际成本直观呈现

价格是模型选型的核心考量因素。通过对比两个模型的官方定价方案,发现存在显著差异。Gemini 2.5 Flash-Lite采用高端定价策略,与其综合能力定位相符。DeepSeek-V3则提供更具竞争力的价格,数量级差异明显。以处理1000篇万字文档(约10亿token输入量)的典型场景为例,DeepSeek-V3在价格上的优势在规模化应用中尤为突出,性价比优势显著。

04 上下文长度:128K的实际价值

两个模型均支持128K超长上下文,这一功能在复杂项目中具有重要价值。超长上下文使模型能处理长文档摘要、代码库分析、学术论文解读等任务。开发者可一次性输入完整项目代码或长篇报告,获得更连贯、准确的分析结果。对于法律文档分析、技术代码审查、学术研究辅助等场景,128K上下文几乎成为必备能力,显著提升任务效率与输出质量。在这方面,两个模型表现相当,都能有效支持长上下文应用。

05 特色与适用场景:如何精准选择?

基于对比数据,可总结两个模型的最佳适用场景:Gemini 2.5 Flash-Lite更适合:需要强大多语言支持的国际业务;对通用推理能力要求高的综合型AI应用;预算充足且重视综合性能的项目。DeepSeek-V3更适合:开发者工具和编程辅助应用;成本敏感的大规模应用;需要处理长上下文但预算有限的项目;代码生成和逻辑推理密集型任务。技术决策者需明确项目核心需求:是追求极致性价比,还是需要超长上下文支持,或是某项特定能力优势。

06 理性选型:数据驱动决策

建议开发团队采用系统化选型方法:首先明确项目核心需求与约束条件,包括性能要求、预算限制、技术兼容性等。然后基于客观数据进行对比分析,避免主观偏见或市场宣传误导。AIbase模型选型对比平台提供便捷的多模型参数和性能指标并排比较功能。这种数据驱动方法能显著提升决策质量,避免常见误区。最终决策应基于实际测试,通过小规模试点评估模型在真实场景中的效果、稳定性、延迟和综合成本。选择大模型没有标准答案,只有最适合方案。Gemini 2.5 Flash-Lite和DeepSeek-V3各有优势领域,关键在于匹配项目具体需求。若正为模型选型纠结,不妨访问AIbase模型选型对比平台(model.aibase.cn/compare),对比详细参数和性能数据。通过数据驱动决策,找到最符合项目需求和预算的方案。在快速演变的大模型生态中,保持理性比较能力比追逐特定模型更重要。基于客观数据和实际需求的选择,才能兼具技术和商业可持续性。