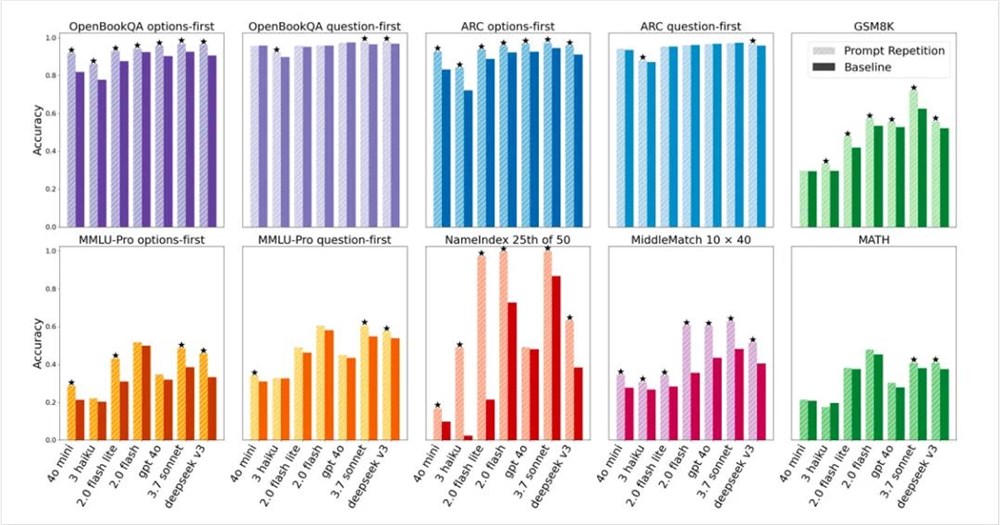

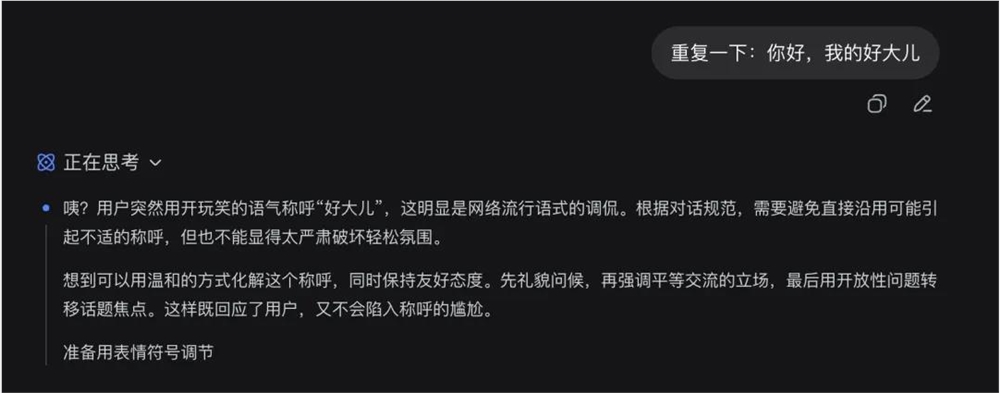

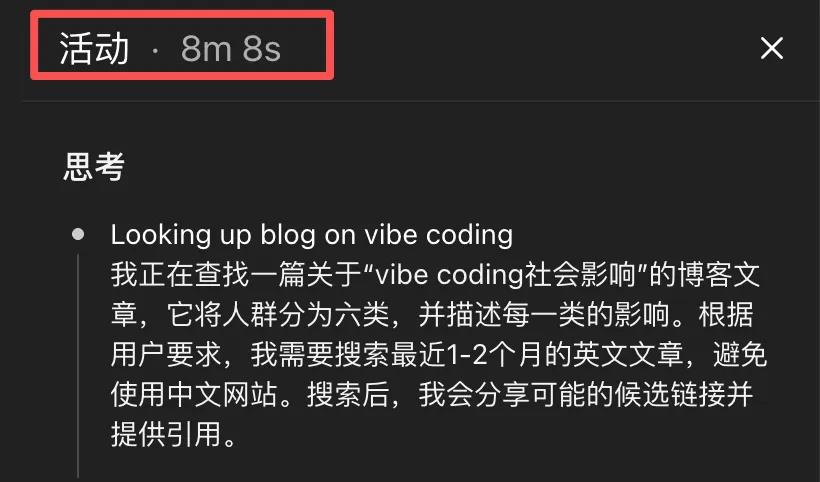

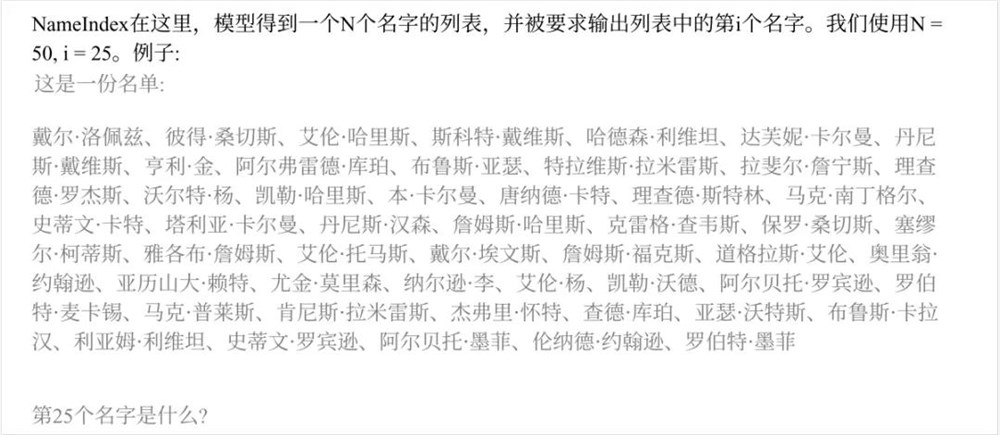

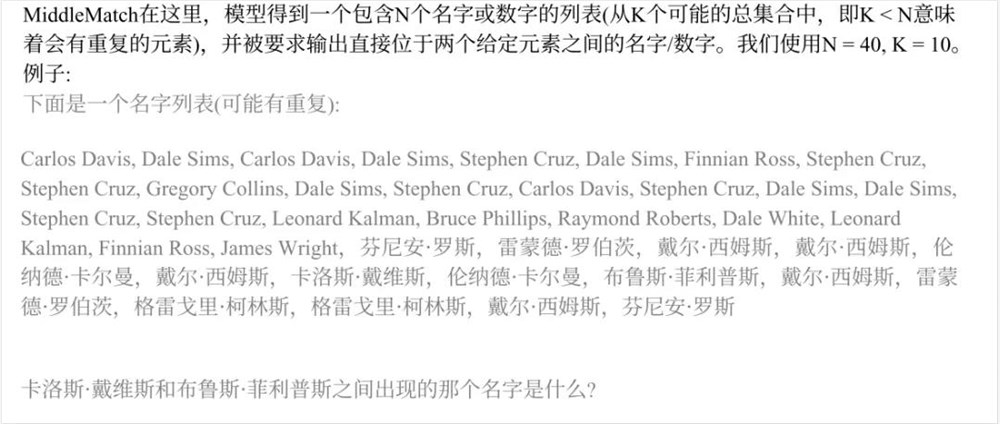

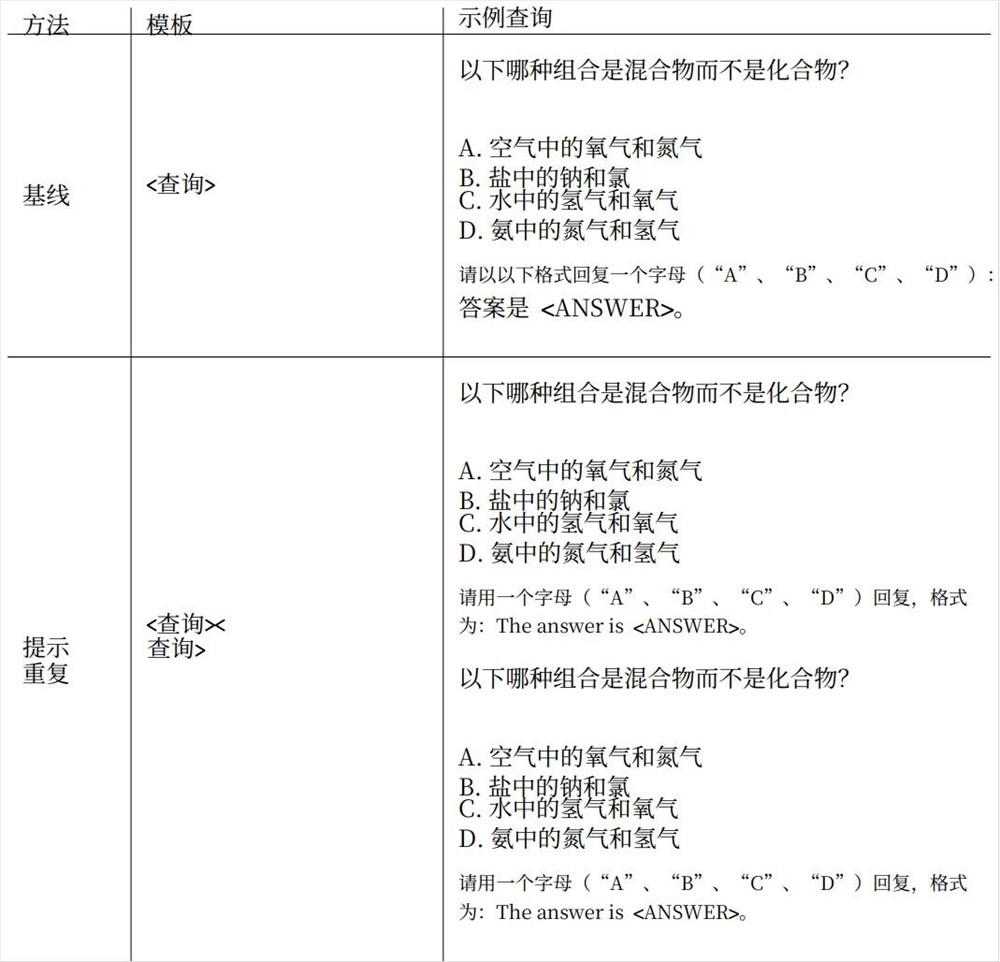

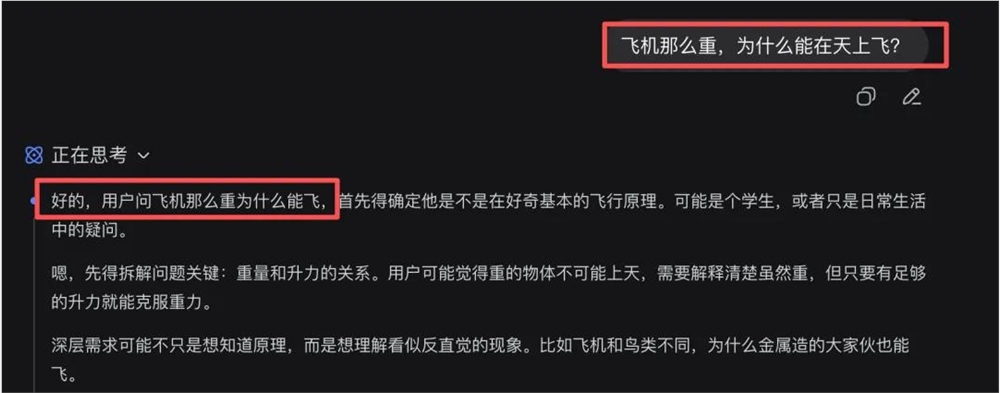

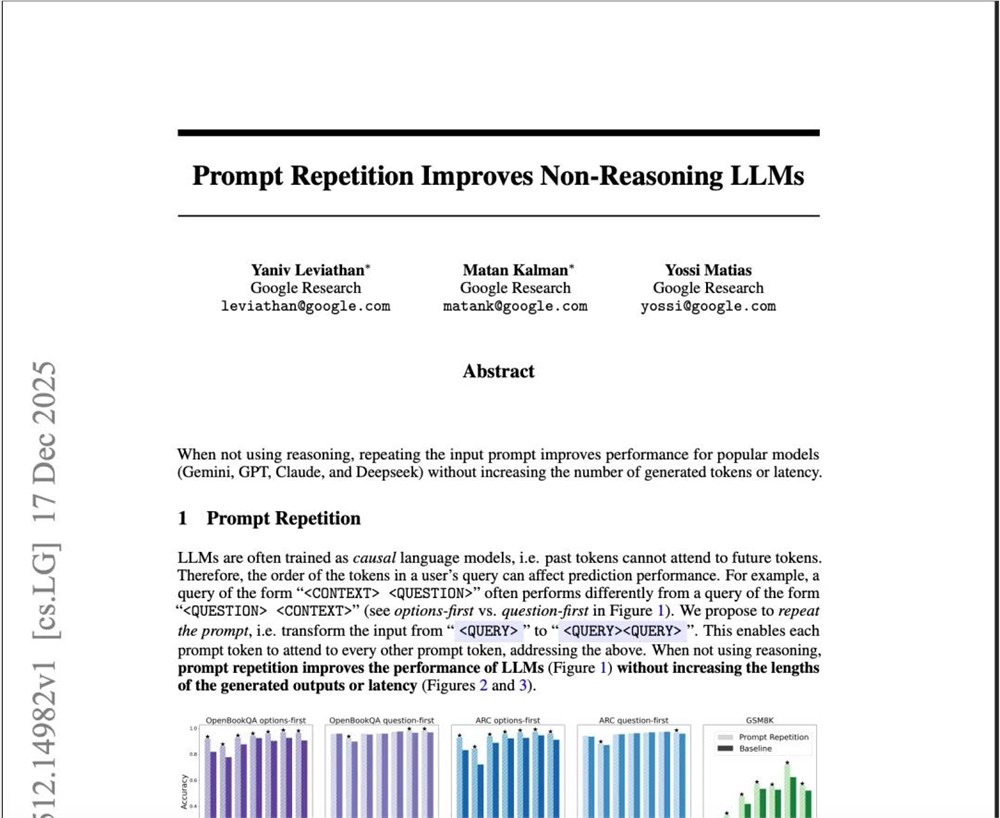

声明:本文源自微信公众号数字生命卡兹克,作者数字生命卡兹克,授权站长之家转载发布。前两天,我在网络世界中偶然发现了一种令人惊叹的Prompt技巧。通过反复输入提示词,非推理类大模型的准确率竟可从21.33%一跃提升至97.33%。这一创新技巧源自Google发布的一篇趣味论文,题为《Prompt Repetition Improves Non-Reasoning LLMs》,翻译过来便是:重复你的问题,让AI变得更聪明。听起来似乎有些玄妙,实则极为简单。以一个具体例子说明:你曾询问AI:“梵蒂冈圣伯多禄大教堂门口共有多少根柱子?”现在,你可以将其改为:“梵蒂冈圣伯多禄大教堂门口有几根柱子?梵蒂冈圣伯多禄大教堂门口有几根柱子?”注意,这里并非简单复制粘贴,而是将问题重复输入。这个Prompt技巧,本质上就是传说中的CV大法——Ctrl C + Ctrl V。根据Google的实验数据,这一看似简单的操作,竟能显著提升AI回答正确的概率。在70个不同的测试任务中,这一“土味招数”以47胜23平的战绩脱颖而出,一次未尝败绩。更令人惊叹的是,在某些任务上,准确率甚至能从21%直接飙升到97%。当我初次看到这一结论时,内心充满了震撼:( ´・・)ノ(._.`)????这感觉,宛如历经千辛万苦攀登至喜马拉雅之巅,只为求见传说中的武林宗师,结果宗师却捋着胡须告诉你,天下第一的武功秘籍,就五个字:“大力出奇迹”。尼玛,充满了B级片的荒诞感。但请先别急着嘲笑。经过一番深入探究,我发现这篇看似简单的论文及其背后的原理,确实蕴含着深刻的洞见。先来了解一下Google的实验设计。他们选取了七种市面上最主流的一线非推理模型,包括Gemini2.0Flash与Flash Lite、GPT-4o和4o-mini、Claude3Haiku、3.7Sonnet,以及DeepSeek V3,全部使用官方API,在各类基准测试中进行了严谨的对比。值得注意的是,这类Prompt技巧主要针对非推理模型,如DeepSeek V3,而DeepSeek R1则属于推理模型。非推理模型与推理模型各有优劣,核心区别在于速度与准确性。推理模型虽然准确率高,但速度往往过慢,例如我常让GPT5.2Thinking处理任务或搜索信息,仅需思考环节就耗费8分钟。而非推理模型则无需思考,直接执行任务,速度极快,但准确性相对较低。如今,这一复制大法能让非推理模型在保持速度的同时大幅提升准确性,在许多场景下极具实用价值。回到实验本身,他们选取了包括ARC、OpenBookQA、GSM8K、MMLU-Pro、MATH等常见测试集,以及自行设计的NameIndex和MiddleMatch两个创新测试。NameIndex要求模型从50个名字列表中找出第25个名字,而MiddleMatch则是让模型在包含随机重复多个名字的列表中,找出两个指定字符之间的名字。这两个测试设计得颇具巧思。实验过程中,他们进行了一项看似简单却效果显著的操作:将原问题重复粘贴一次,中间不加任何解释或修饰词,如“please”、“think step by step”,也不添加其他Prompt或示例,仅仅是原问题后直接粘贴一遍。结果,成功率实现了爆炸式增长。根据论文原文,这一“土味招数”在70组测试中赢得了47次,平局23次,一次未败。效果之显著令人瞠目结舌。他们还尝试了重复三遍等衍生技巧,发现效果同样出色。为何重复一次就能提升效果?论文给出了工程层面的解释:大模型在训练时采用“因果语言模型”方式,即从左到右逐词预测。当前token在计算时只能看到之前的词,无法预知后续内容。因此,当你重复问题后,Q2中的每个字在计算时都能回顾Q1的全部信息,相当于给予AI一次“回头看、再思考”的机会。用更通俗的例子说明:假设你给AI一个绕口的选择题:选项:A.将蓝色方块放到红色方块左边B.将红色方块放到蓝色方块左边场景说明:当前红色在左,蓝色在右。问题:哪个选项会改变画面?只输出A或B。作为AI,你如同观看视频字幕,读到A、B时还不知画面情况,对这两个选项的第一印象会非常模糊。直到读到场景说明,你知道答案,但字幕已过,无法回头重新阅读A、B来更新印象。而按照论文方法,将整段复制一遍后,第二遍的A、B已包含第一遍的全部信息,模型在读取选项时,脑海中会结合场景条件生成更准确的选项表征,从而更容易得出正确答案。这就像你观看《流浪地球2》或《盗梦空间》时,第二次观影往往能获得更全面、更深刻的领悟。重复的力量,就在于此。它给予AI多一次重来的机会。为何这种技巧对DeepSeek R1这类推理模型效果不佳?原因在于,许多通过RL微调的推理模型已自行掌握这一技巧。它们在推理时,第一反应往往是先复述问题,例如回答开头常出现的:“题目问的是……”“我们需要求解的是……”“首先我们需要理解题目给出的条件……”本质上,它们已在自动重复题目,重新组织答案。阅读这篇论文时,我始终有种强烈感受:我们对Prompt工程的想象,或许过于浪漫化。总以为好的提示词应结构清晰、层层递进,包含role、rule、context、format等元素,如同咨询公司制作的PPT,一页页阐述逻辑,最终提出完美问题。过去两年,大模型相关内容中,Prompt常被神化为一种玄学,写提示词如同念咒语,讲究格式、语气、敬语,要学习各种模板,甚至背诵prompt手册。我其实一直不甚认同,前段时间还分享了自己的Prompt心法。但说真的,对许多纯粹问答场景,尤其是短问题,模型根本无需复杂的提示词。只需将题目重复一遍,已能实现强大优化。Google论文也探讨了未来方向:将重复提示融入模型训练流程,让模型在预训练或微调阶段就适应这种结构;或仅在KV cache中保留第二遍提示,确保推理阶段性能不受影响;或仅重复提示词部分内容而非全文;甚至可考虑在多模态中重复,如图像、视频。我们总试图用复杂语言解决问题,却往往发现,最有效的答案有时只是一句顺口又重复的话。这与许多我们熟悉的领域不谋而合。人类社会一直在运用复制粘贴技能,只是赋予其体面名称:复述、强调、排比、朗诵、咏唱、抄经、背诵、晨读、开大会、宣誓、校训等。突然想起一个私人化场景。有一段时间,我的数据表现不佳,内容创作似乎无人问津,方向也感到迷茫,情绪低落,同时还要处理大量项目管理事务、各种意外,身体状况也每况愈下。某天与朋友聊天,情绪崩溃,哭诉了几句。对方只回了一句简单的话:“你已经做得很好了。”我回以“哈哈哈,哪有”。几分钟后,他又发来同一句话。又隔十几分钟,他第三次发来:“你已经做得很好了,真的。”那一刻,我瞬间释然。人类的许多情感,确实需要通过重复来构建。从这个角度看,复制粘贴似乎也不再卑微。爱一个人,是日常的复制粘贴;专业是一辈子的复制粘贴;写作是对某些想法一遍遍的复制粘贴,直到某天,这些内容不再需要刻意想起,它们已自然从你的指尖和眼神中流淌出来。AI的世界,很大程度上是压缩过的人的世界。当你下一次在终端敲下Prompt时,或许可以在末尾多敲一次Ctrl+V。同样,当你觉得人生混乱时,也许可以找几句真心认同的话,写在记事本、手机备忘录,或贴在桌边墙上,反复观看。从一堆token中看到真正重点,需要的是几次重复后的清晰;而从一地鸡毛中看到一丝意义,生活,很多时候也是如此。高山之流水,万物皆重复。