在人工智能飞速发展的今天,Yann LeCun 提出的 JEPA(联合嵌入预测架构)正引领一场关于大语言模型(LLM)训练方式的革命。这位诺贝尔奖得主并未选择批评现有技术,而是亲自投身于创新实践,致力于突破传统LLM训练方法的瓶颈。传统方法主要依赖输入空间的重构与生成,例如预测下一个单词,但在视觉领域已被证明存在明显局限。LeCun及其团队敏锐地意识到,计算机视觉(CV)领域的先进技术能为语言模型带来突破性进展。JEPA的核心突破在于,它通过在抽象表征空间中预测缺失特征,实现了对世界知识的高效学习。Meta AI团队在图像和视频处理领域已成功验证了JEPA的强大能力,现在他们正雄心勃勃地将这一理念拓展至语言模型领域。

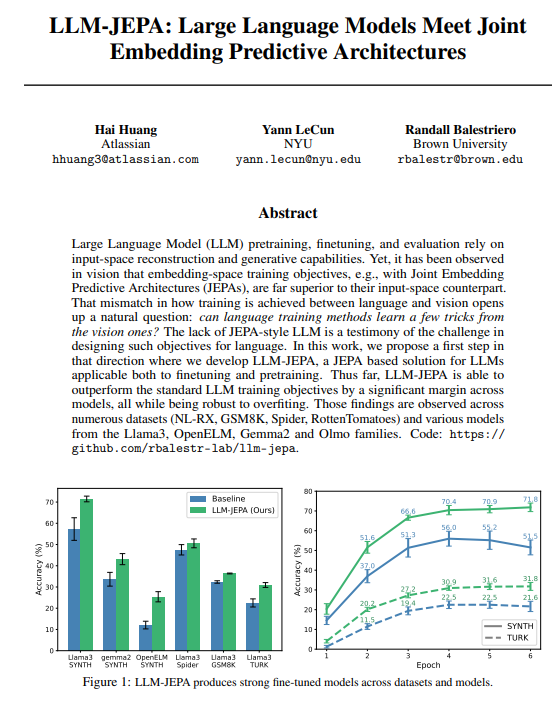

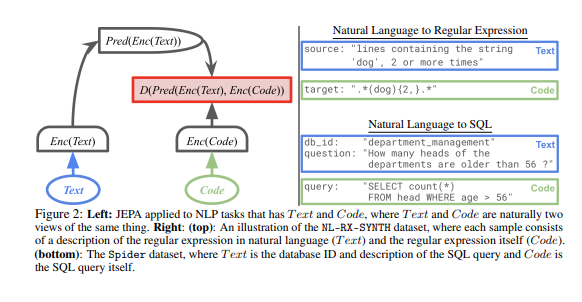

为了填补这一重要空白,研究人员Hai Huang、Yann LeCun和Randall Balestriero联合提出了LLM-JEPA这一创新模型。该模型开创性地将文本和代码视为同一概念的不同视角,首次成功将JEPA的自监督学习架构应用于LLM。通过融合JEPA在嵌入空间学习的独特优势,LLM-JEPA不仅完整保留了LLM强大的生成能力,更在性能和鲁棒性上实现了跨越式提升。实验数据有力证明,LLM-JEPA在Llama3、OpenELM、Gemma2等主流模型上表现卓越,并在GSM8K、Spider等多样化数据集上显著超越传统LLM训练目标。尤为突出的是,该模型在防止过拟合方面展现出强大鲁棒性,为语言模型的未来发展开辟了新路径。

尽管目前研究主要聚焦于微调阶段,但初步预训练结果已展现出惊人的潜力。团队计划在后续工作中深入探索LLM-JEPA在预训练过程中的应用,期待为语言模型性能提升注入新的活力。这一突破性进展不仅重新定义了LLM的训练范式,更预示着人工智能领域即将迎来新一轮的技术革新浪潮。