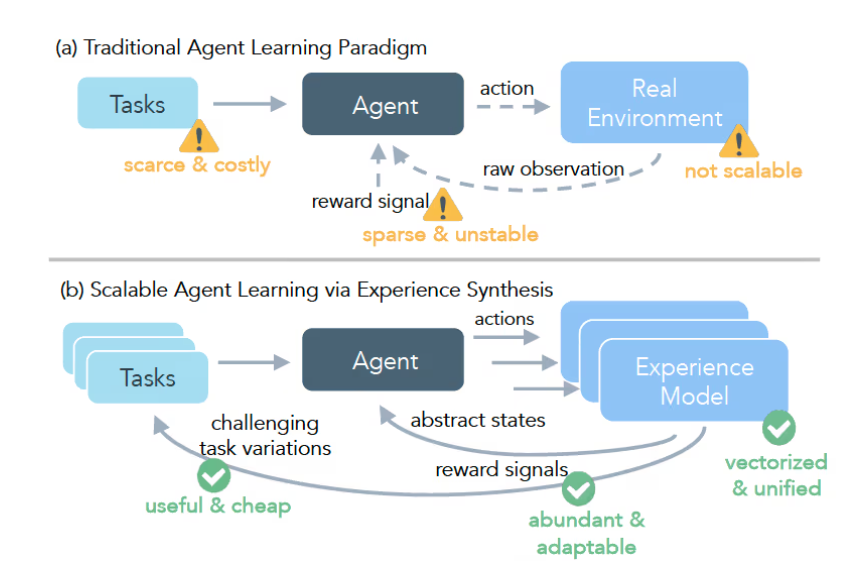

Meta 公司联合芝加哥大学与加州大学伯克利分校的顶尖科研团队,共同研发出突破性框架——DreamGym,旨在攻克强化学习(RL)训练大型语言模型(LLM)代理时面临的高昂成本、复杂基础设施及反馈不可靠等核心难题。DreamGym 以模拟 RL 环境为核心创新点,通过高度逼真的虚拟场景,使 AI 代理能够在高效、可控的环境中完成复杂应用操作,显著提升训练效率与稳定性。该框架具备动态任务难度调节机制,能够根据代理的学习进度智能调整挑战等级,确保其循序渐进地掌握并攻克更高难度的任务。研究团队通过严谨的实验验证,证明 DreamGym 在完全模拟环境及模拟与现实结合的应用场景中,均能大幅提升 RL 训练效果。特别是在成本高昂的 RL 应用领域,DreamGym 仅依靠合成交互数据即可实现与主流算法相媲美的性能表现,将数据收集与环境交互成本降低至前所未有的水平。

当前,使用强化学习训练 LLM 代理仍面临诸多现实挑战。实际应用中,代理往往需要执行长时间的操作序列,且反馈信号呈现稀疏特性,即只有在连续完成一系列正确操作后才能获得正向激励。此外,构建高质量训练数据集的成本极高,通常需要投入大量人力进行验证与标注。针对这些痛点,DreamGym 提供了一种兼具高效性与安全性的创新解决方案。该框架由三大核心组件协同构成:首先是”基于推理的经验模型”,其通过先进推理技术将目标环境的动态变化转化为可处理的文本空间,从而构建出高度仿真的虚拟应用环境;其次是”经验重放缓冲区”,作为动态记忆库,不仅存储历史经验数据,更通过智能算法指导经验模型的预测方向,确保合成经验的多样性与实用性;最后是”课程任务生成器”,该组件能够实时监测代理表现,自动生成难度递增的新任务,形成完整的闭环训练系统。这三者无缝协作,共同推动 AI 代理实现高效学习与成长。

研究者对 DreamGym 的综合性能进行了多维度基准测试,涵盖电子商务智能客服、体感游戏控制以及真实网页交互等前沿领域。测试结果显示,DreamGym 在所有测试场景中均展现出卓越性能,特别是在 WebArena 环境下,训练出的代理成功率较基线方法提升超过30%。这一突破性成果不仅验证了 DreamGym 的技术优势,更为以往因成本过高或技术限制而难以实现 RL 训练的应用领域,开辟了全新的解决方案路径。划重点:🌟 DreamGym 通过模拟环境训练 AI 代理,大幅降低 RL 训练成本与风险。 🚀 该框架创新性地实现任务难度动态调节,助力代理系统性地攻克复杂问题。 💡 多领域实验数据有力证明,DreamGym 的训练效果显著超越传统方法,为 AI 发展注入新动能。