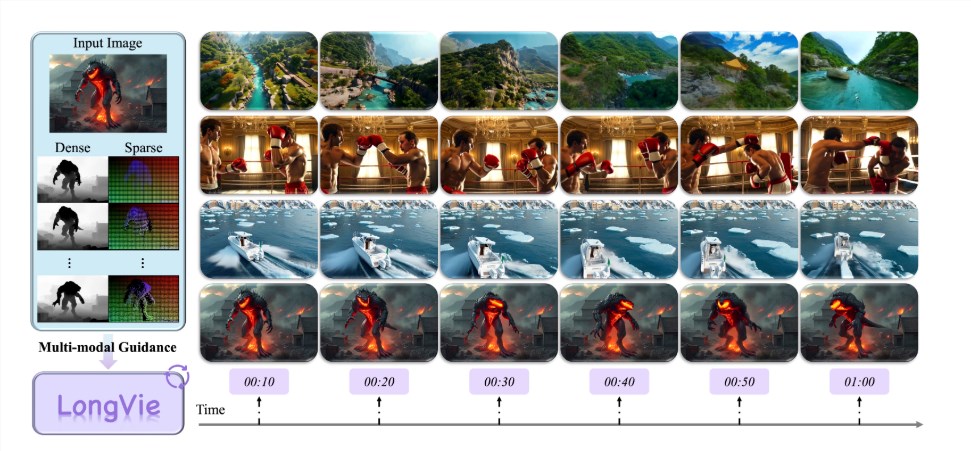

近年来,视频生成技术发展迅猛,尤其在短视频创作领域取得了突破性进展。然而,如何制作出超过一分钟且风格统一的高质量超长视频,始终是一个亟待解决的难题。针对这一挑战,上海人工智能实验室联合南京大学、复旦大学、南洋理工大学 S-Lab 以及英伟达等顶尖机构,共同研发了 LongVie 框架,为超长视频生成领域带来了革命性突破。LongVie 的核心目标在于提升超长视频生成的可控性与一致性,确保视频在长时间段内依然保持高质量和连贯性。

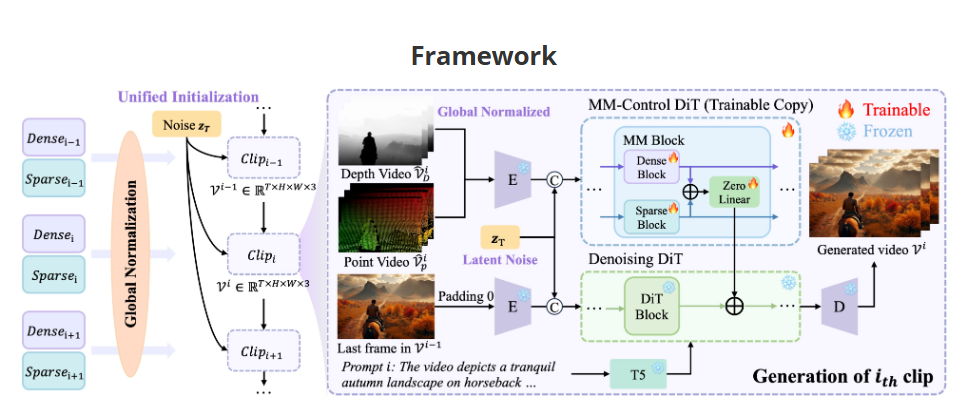

传统视频生成模型在处理长视频时,普遍存在时序不一致和视觉退化两大难题。时序不一致主要表现为画面细节与内容之间的脱节,而视觉退化则指随着视频时长的增加,画面颜色饱和度、清晰度逐渐下降。为攻克这些难题,LongVie 从“控制信号”和“初始噪声”两个维度进行创新性设计。首先,团队提出“控制信号全局归一化”策略,通过统一整个视频段的控制信号,显著提升跨片段的连贯性,避免传统模型在单一片段内归一化导致的时序断裂。其次,LongVie 引入“统一噪声初始化”机制,确保所有片段共享同一初始噪声,从源头上减少视觉漂移,使视频整体风格保持高度一致。

在解决视觉退化问题上,LongVie 采用多模态精细控制方法。单一模态的控制往往难以提供稳定约束,而 LongVie 创新性地结合了密集控制信号(如深度图)和稀疏控制信号(如关键点),并引入退化感知训练策略。这一组合拳使得模型在处理长视频时,能够精准控制画面细节,保持更高的画质和纹理清晰度,有效避免视觉质量随时长下降的问题。

为推动该领域的研究与评测,LongVie 团队还推出了 LongVGenBench,这是首个专为可控超长视频生成设计的基准数据集。该数据集包含100个超过1分钟的高分辨率视频,为研究人员提供了标准化测试平台。根据定量指标和用户评测结果,LongVie 在多个评估维度上超越了现有技术,达到了 SOTA(最先进技术)水平,赢得了用户的高度认可与偏好。

LongVie 框架的问世,标志着超长视频生成技术迈入全新时代。创作者们将能够以更大的自由度实现创意,制作出更长、更高质量且风格统一的视频作品。这一突破不仅推动了视频生成技术的发展,也为影视制作、广告营销等领域带来了无限可能。项目地址:https://vchitect.github.io/LongVie-project/