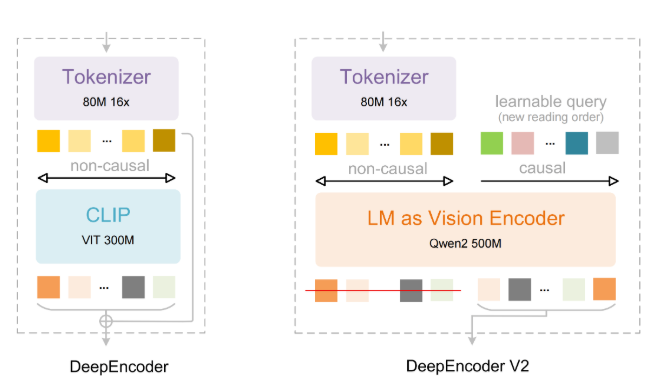

微新创想:中国 AI 领军企业 DeepSeek 近日发布了全新的视觉编码器 DeepSeek OCR2 在文档处理和图像识别领域实现重大突破。该模型通过模拟人类视觉的灵活扫描模式 彻底颠覆了传统视觉模型平铺直叙的处理逻辑。DeepSeek 研究人员指出 人类眼睛在观察物体时会根据内容进行灵活聚焦。为了实现这一特性 DeepSeek OCR2 引入了全新的架构 弃用了传统的 CLIP 组件 转而采用轻量级语言模型架构。

该架构利用“因果流 Token”对视觉信息进行重新排列和上下文整合 使 AI 能够像人类一样 根据内容的意义而非固定的网格顺序来“观察”世界。这种创新的处理方式不仅提升了理解力 更极大地优化了效率。在相同的图像处理任务中 DeepSeek OCR2 仅需 256 到 1120 个 Token 相比同类系统通常消耗的 6000 个以上 Token 其视觉 Token 消耗量锐减了 80% 以上。这种极高的压缩率使得模型在处理长文档时具有巨大的成本和速度优势。

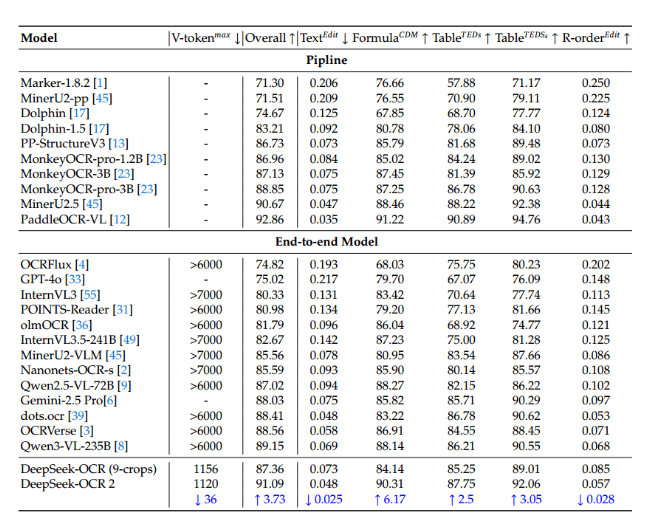

在权威的 OmniDocBench 基准测试中 该模型以 91.09% 的高分刷新纪录 在文档解析性能上全面超越了 Gemini3Pro。目前 DeepSeek 已将该模型的代码和权重向公众开放。研究团队认为 这种架构是迈向统一多模态处理的重要一步 未来有望在同一框架下实现文本、语音和图像的深度融合理解。

能效巅峰 DeepSeek OCR2 将单张图像的视觉 Token 需求大幅降低 相比同类系统减少了约 80% 的资源消耗。性能超越 在 OmniDocBench 测试中 该模型在文档解析和识别阅读顺序方面表现卓越 准确率超越了 Gemini3Pro。架构创新 通过引入“因果流 Token”重组视觉信息 模型实现了从机械扫描到理解内容逻辑的跨越。