微新创想:大模型落地端侧的“减脂增肌”迎来重大突破

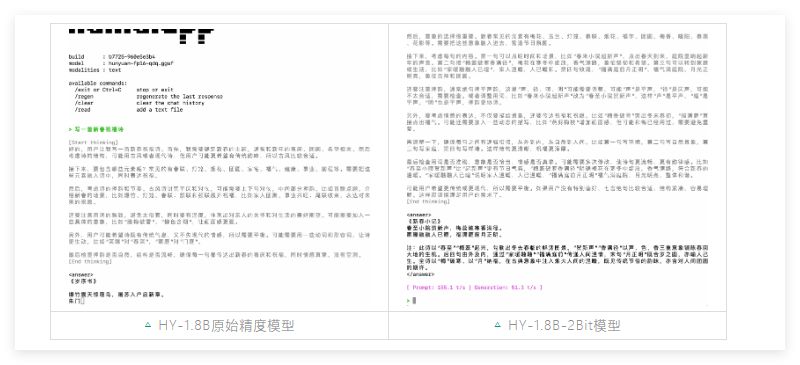

腾讯混元今日正式发布面向消费级硬件的极小模型 HY-1.8B-2Bit。该模型通过首个产业级2Bit量化方案将等效参数量精简至0.3B 内存占用仅约600MB 体积甚至小于部分常用的手机应用

技术突破 2Bit量化的“不可能任务”在模型部署中 量化位数越低 精度损失通常越大 为攻克这一难题 腾讯混元团队放弃了传统的PTQ(后量化)策略 转而采用量化感知训练(QAT)并结合数据优化 弹性拉伸量化及策略创新 实验数据表明 HY-1.8B-2Bit在数学 代码及科学等核心指标上 表现已能与4Bit PTQ模型版本持平 这意味着在大幅压缩体积的同时 模型依然保持了极强的“全科能力”

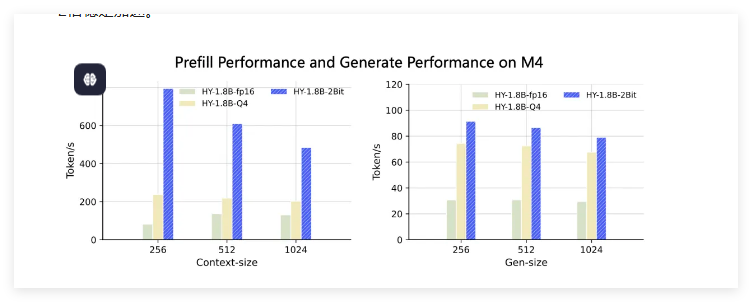

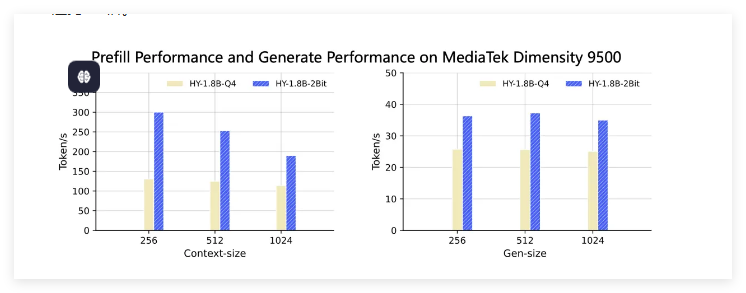

性能表现 生成速度翻倍 适配多种硬件 得益于极致的压缩 该模型在真实端侧设备上的生成速度对比原始精度模型提升了2—3倍 具体表现如下 MacBook M4 在1024输入内 首字时延实现3~8倍加速 生成速度保持2倍以上稳定提升 天玑9500 对比Q4格式 首字时延加速1.5~2倍 生成速度加速约1.5倍

全思考能力 沿用Hunyuan-1.8B-Instruct的长短思维链能力 用户可根据任务复杂度灵活切换

未来布局 目前该模型已提供GGUF-int2格式权重 并在Arm SME2技术平台上完成适配 可广泛应用于手机 耳机及智能家居等对离线部署和隐私有极高要求的场景 腾讯混元表示 未来将通过强化学习与模型蒸馏 进一步缩小低比特模型与全精度模型的能力差距