近日,Meta 公司正式宣布成立全新的超级智能实验室(Meta Superintelligence Labs,MSL),并发布了首篇具有里程碑意义的重要论文。该研究成果显著提升了大语言模型在检索增强生成(RAG)任务中的推理速度,实现了高达30倍的惊人提升。这篇题为《REFRAG:Rethinking RAG based Decoding》的论文,深入探讨了如何让大型语言模型在执行 RAG 任务时,能够快速精准地提炼关键信息,从而大幅减少计算量并缩短响应时间,同时确保输出结果的准确性。

Meta 超级智能实验室的成立,标志着公司在人工智能领域的战略布局迈出了关键一步。在当前竞争日益激烈的科技环境下,Meta 董事长扎克伯格展现出对 AI 技术发展的迫切决心。该实验室于今年6月正式落户加利福尼亚州门洛帕克,专注于研发前沿的超级智能技术。据内部消息,扎克伯格在4月份对 Meta 最新发布的 Llama4 模型表现并不满意,甚至亲自要求员工加班加点进行改进。这一压力促使他迅速成立了新实验室,并引进了包括 Scale AI 创始人 Alexandr Wang 在内的大量顶尖人才。

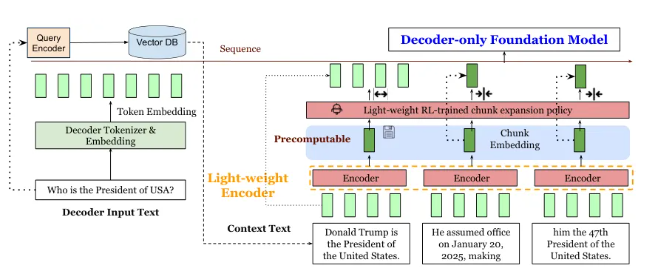

实验室内部设立了四大核心研究小组,分别负责大语言模型的研发、人工智能基础理论探索、产品技术落地以及基础设施保障。REFRAG 框架的提出,正是该实验室在优化大语言模型性能方面的突破性成果。其核心理念是通过一个轻量级模型将冗长的上下文内容压缩成精简摘要,从而显著减少解码器需要处理的输入信息量。这种方法不仅大幅提升了处理速度,还有效降低了计算成本,实现了模型效率的飞跃。

研究团队还创新性地采用了“持续预训练”技术,通过重建任务训练模型,在压缩信息的同时最大限度地保留关键细节。经过全面的多任务测试,REFRAG 表现出卓越的性能,尤其在时间延迟和吞吐量方面实现了革命性提升。实验数据显示,在压缩比达到16倍的情况下,REFRAG 的处理速度不仅超越了此前最先进的 CEPE 模型,而且在准确性上几乎未受影响。

这一创新成果为 Meta 在人工智能领域的发展注入了强劲动力,同时也彰显了其在提升大模型推理效率方面的远见卓识。论文链接:https://arxiv.org/abs/2509.01092

划重点:

🌟 Meta 成立超级智能实验室,彰显其在 AI 领域的战略雄心。

⚡ 新论文《REFRAG》实现 RAG 推理速度30倍提升,开创效率革命。

🚀 REFRAG 框架通过智能信息压缩技术,同步提升大语言模型的处理速度与准确性。