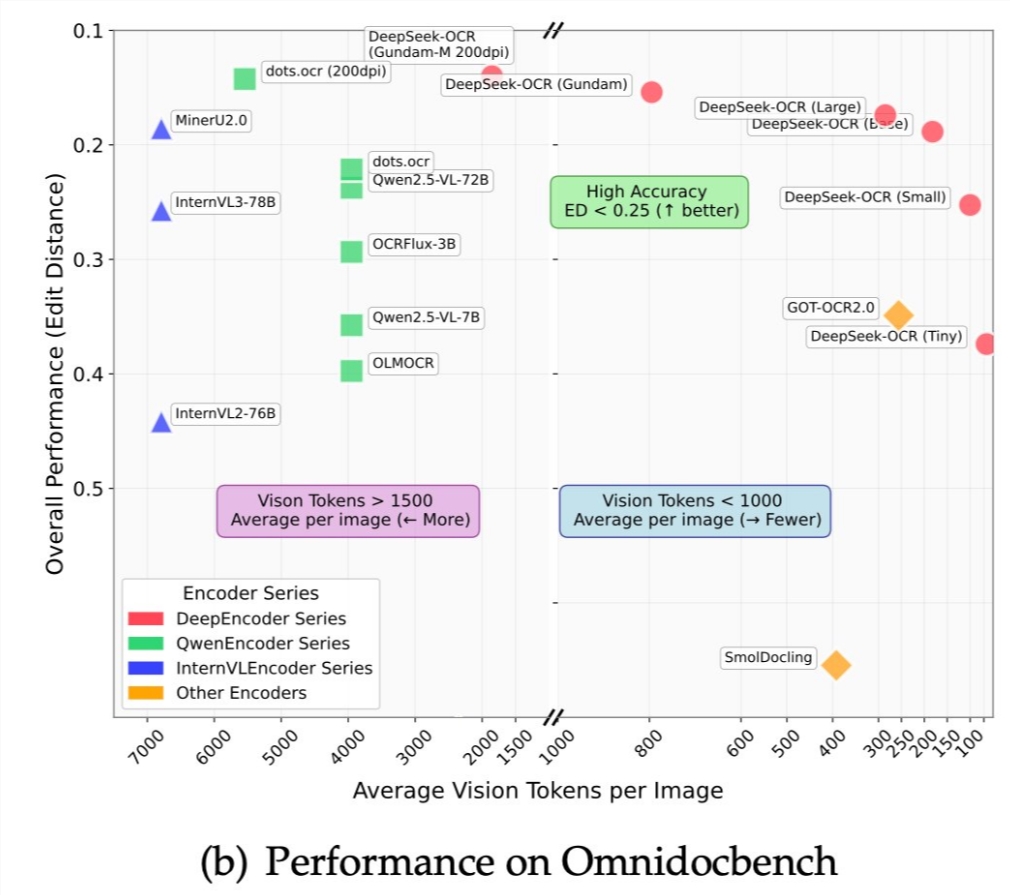

特斯拉前自动驾驶负责人、OpenAI联合创始人Andrej Karpathy近日在推特上对开源的DeepSeek-OCR论文发表了精辟评论,提出了一个颠覆性的观点:图像输入或将成为大语言模型(LLM)更高效的交互方式。这一观点迅速引爆AI研究社区,引发了一场关于模型输入范式未来走向的深度探讨。

Karpathy指出,当前主流的文本token输入方式存在明显缺陷,效率低下且资源浪费。他认为,图像作为信息载体,在传递给LLM时具有天然优势。他从三个关键维度阐述了这一观点的合理性。首先,图像输入实现了信息的高效压缩。通过将文本渲染为视觉patch,单个图像单元可以承载多个字符信息,而传统文本tokenization需要为每个字符或子词分配独立token。这种差异在处理海量上下文时尤为显著,能够大幅提升模型效率并降低计算成本。其次,图像输入支持更丰富的语义表达。视觉元素如加粗、颜色、字体变化和文档布局等格式信息,在纯文本中要么完全丢失,要么需要复杂的标记语言(如Markdown)表示,后者反而增加token消耗。图像输入让模型能够直接感知文档的视觉结构和重点区域。第三,图像输入为注意力机制提供了更优化的实现路径。视觉模型可采用双向注意力机制,同时捕捉上下文全貌,而传统文本生成通常依赖自回归的因果注意力,存在处理局限。这种差异使图像输入在理解能力上更具优势。

Karpathy特别批评了tokenizer这一历史遗留模块。他认为tokenizer作为非端到端组件,引入了不必要的复杂性。例如,相同视觉字符可能因不同Unicode编码映射为不同token,导致模型对相似输入产生歧义。直接采用图像处理技术,将使整个系统更加简洁高效。从技术实现角度,Karpathy的观点建立在视觉编码技术日趋成熟的现实基础上。Vision Transformer等架构已能高效处理图像输入,而DeepSeek-OCR等模型证明视觉到文本的转换已达到工业级精度。将这种能力扩展到所有文本处理任务,在技术上完全可行。

然而,Karpathy也指出了这一方案的不对称性:用户输入可以是图像,但模型输出仍需保持文本形式,因为图像生成技术尚未成熟。这意味着模型架构必须兼顾图像输入和文本输出能力。这一观点引发了多维度的讨论。从效率角度,图像输入在处理长文档和大规模上下文时优势明显。从统一性角度,图像输入可将文档理解、OCR、多模态问答等任务整合到同一框架。但图像输入也面临挑战:首先是计算成本,图像编码本身的高开销可能抵消部分效率优势;其次是可编辑性,图像形式的”文本”难以像字符那样灵活编辑;第三是生态兼容性,现有大量文本数据和工具链基于字符表示,全面转向图像输入需要重构整个技术生态。

从研究视角看,Karpathy的观点预示着语言模型的范式转变:传统”语言模型”可能演变为更通用的”信息处理模型”,其中文本仅是信息呈现形式之一。这种转变将模糊语言模型和多模态模型的界限。DeepSeek-OCR论文正是这一讨论的催化剂,表明OCR已从字符识别升级为文档理解。若OCR能准确解析各种格式和布局,将所有文本任务视为”视觉理解”在概念上完全合理。Karpathy的自嘲——”得控制住不要立刻去开发只支持图像输入的聊天机器人”——既表达了对这一想法的浓厚兴趣,也暗示了实际落地的复杂性。这种激进架构转型需要大量实验验证,同时解决上述挑战。

从产业应用看,即使图像输入最终胜出,过渡也将循序渐进。更现实的路径是混合模式:在需要保留视觉格式的场景使用图像输入,在需要灵活编辑的场景保留文本输入。这种策略可兼顾两种方式优势。总体而言,Karpathy的观点为模型输入优化提供了全新视角,挑战了文本token作为标准输入的固有假设。无论这一愿景最终实现程度如何,它都必将催生新一代更高效、更统一的AI架构,为人工智能发展注入新动能。