月之暗面近日震撼发布了一项突破性技术——”Kimi Linear”混合线性注意力架构,这一创新设计在短距离文本处理、长距离序列建模以及强化学习等多个领域展现出超越传统全注意力方法的卓越性能。其核心突破在于”Kimi Delta Attention”(KDA)机制,这是对Gated DeltaNet的深度优化升级,通过引入更精密的门控机制,实现了对有限状态RNN记忆的高效利用。

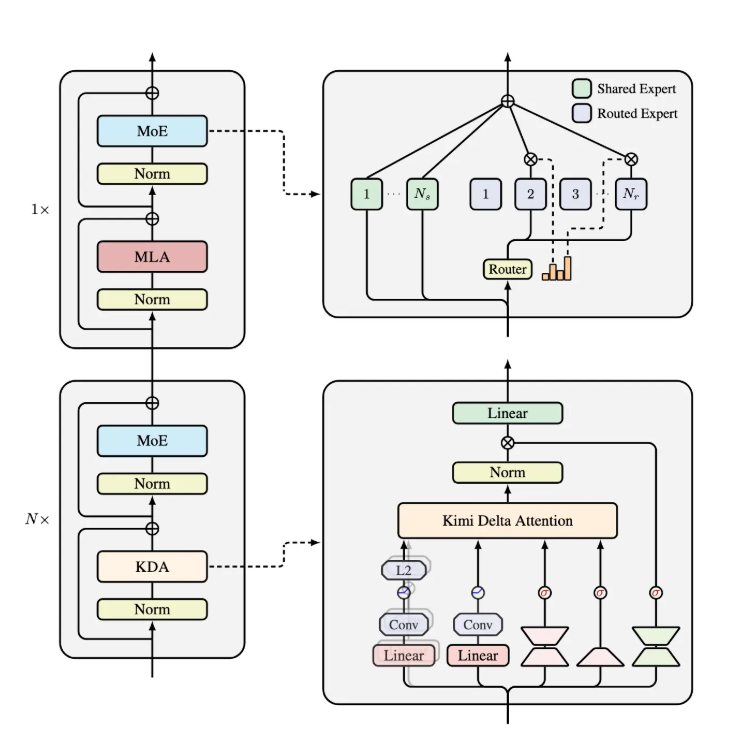

Kimi Linear的独特架构由三组Kimi Delta Attention模块与一组全局多层感知机(MLA)协同组成。通过对Gated DeltaNet的改良,KDA能够通过细粒度的门控控制机制,显著压缩有限状态RNN的记忆需求。这一创新设计不仅大幅提升了模型处理信息的速度,更有效降低了内存占用,展现出极高的实用价值。

官方测试数据显示,在处理1M token的复杂场景下,Kimi Linear的KV cache占用量减少了惊人的75%,解码吞吐量最高可达传统方法的6倍。在训练速度(TPOT)方面,相较于传统MLA架构,Kimi Linear实现了6.3倍的显著加速。这些突破性的性能提升,预示着Kimi Linear将在各类AI任务中展现出广泛的应用潜力,特别是在对速度和内存资源要求严苛的应用场景中。

随着人工智能技术的飞速发展,提升模型处理能力与效率已成为行业面临的核心挑战。月之暗面推出的Kimi Linear架构,通过其创新设计为这一领域带来了全新的解决方案,有望成为未来AI技术的新标杆。对Kimi Linear技术报告感兴趣的用户,可通过官方GitHub页面获取详细的技术细节资料。

技术报告获取链接:https://github.com/MoonshotAI/Kimi-Linear/blob/master/tech_report.pdf