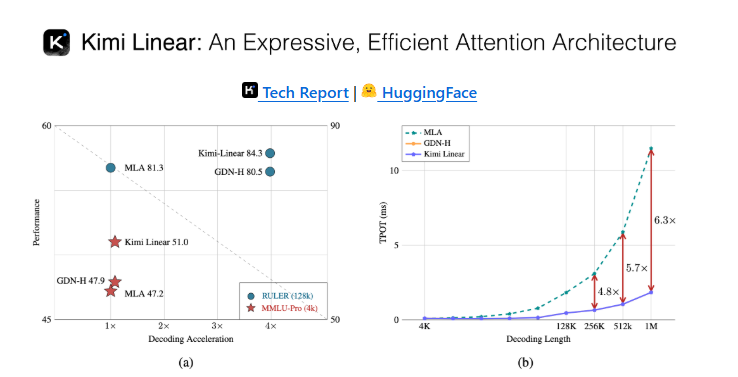

在人工智能生成内容(AIGC)领域,月之暗面团队凭借其前瞻性的技术探索,成功推出了具有革命性意义的 Kimi Linear 模型,实现了突破性的性能飞跃。这一创新模型在处理长上下文信息时,速度显著提升2.9倍,解码效率更是提高了惊人的6倍,从而成功打破了传统全注意力机制长期存在的性能瓶颈。Kimi Linear 的核心突破在于其创新的混合线性注意力架构,该架构在上下文深度处理、强化学习等多个关键应用场景中,均展现出超越主流 Softmax 注意力机制的综合表现。

传统 Transformer 模型普遍采用 Softmax 注意力机制,其计算复杂度高达 O(n²),导致在处理长文本时,计算量与内存消耗呈现指数级增长,严重制约了模型的实际应用范围。而 Kimi Linear 通过引入线性注意力机制,将这一复杂度精简至 O(n),实现了处理效率的质的飞跃。值得注意的是,尽管线性注意力在理论上具有显著优势,但早期版本在长序列记忆管理方面仍存在明显短板,影响了整体性能表现。

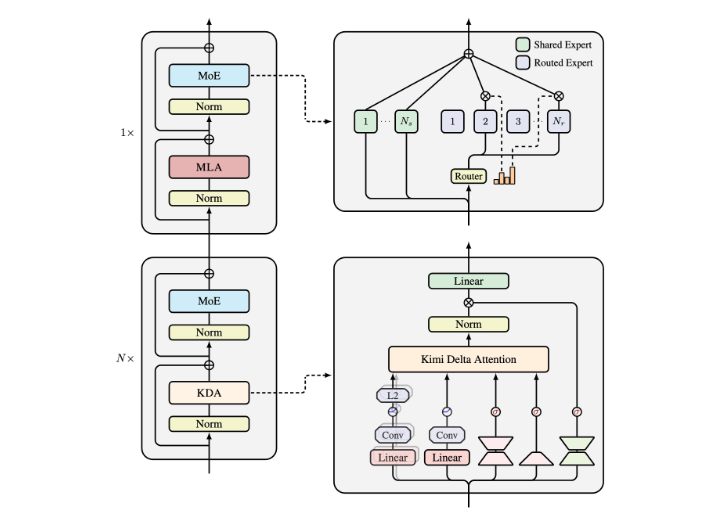

Kimi Linear 模型的核心创新在于其自主研发的 Kimi Delta Attention(KDA)机制。这一突破性技术通过引入精密的门控控制机制,实现了对模型记忆状态的动态调节,能够根据输入内容实时优化信息的遗忘与保留策略,从而显著提升长时间交互场景下的信息处理能力。更为关键的是,Kimi Linear 还创新性地采用了 Moonlight 架构,将 KDA 与全注意力层按照3:1的比例进行混合配置,这种精妙的架构设计在保证模型强大能力的同时,有效降低了计算成本,实现了效率与性能的完美平衡。

经过一系列严谨的实验验证,Kimi Linear 在多个核心任务上展现出卓越表现,特别是在需要长上下文记忆的回文生成和多查询关联记忆等任务中,其准确率较前代模型实现了大幅提升,充分证明了细粒度控制机制的优势。这一系列技术创新不仅显著提升了长上下文处理的效率,更为人工智能生成领域开辟了新的技术路径

划重点:

🌟 Kimi Linear 模型在长上下文处理上速度提高2.9倍,解码速度提升6倍

🔍 采用 Kimi Delta Attention(KDA)创新机制,优化记忆管理与信息遗忘

📈 通过3:1混合架构设计,平衡计算效率与模型性能,实验结果显示出卓越能力