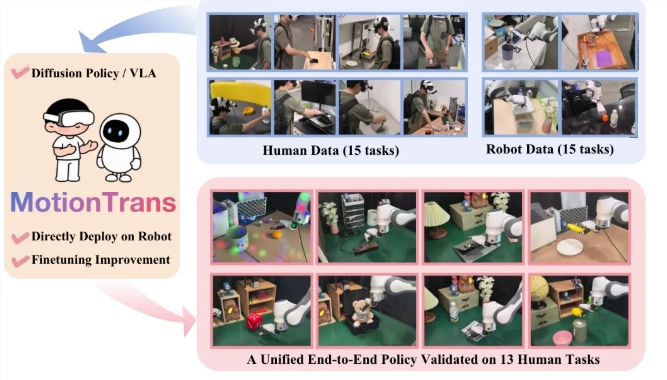

近日,清华大学、北京大学、上海交通大学与武汉大学等顶尖高校强强联手,共同推出了一项革命性的人机协同训练框架——MotionTrans。这一创新框架的核心突破在于,使机器人能够在完全缺乏示范的情况下,仅通过观察人类的动作,便能自主学习并执行全新技能,这标志着机器人学习领域迈出了历史性的一步。

传统的机器人训练模式依赖于海量的真实演示数据,而收集这些数据不仅耗时费力,成本高昂。以教机器人拧瓶盖为例,需要操作人员反复演示并精确记录每一个细节。然而,MotionTrans 通过引入虚拟现实(VR)技术,巧妙地解决了这一难题。研究人员利用便携式 VR 设备,让参与者随时随地进行动作录制。系统不仅捕捉佩戴者手部的关键点数据,还同步记录第一人称视角的视频,从而确保了训练数据的高质量与丰富性。经过团队的努力,最终建立了一个包含 3,213 个演示的庞大数据集,涵盖了从日常生活到工业应用的多种人类与机器人协作任务。

MotionTrans 的核心技术在于将人类动作数据转化为机器人可识别的指令语言。研究者们通过算法优化,将人类手部动作的每一个细微之处精确映射到机器人的关节角度,使机器人能够在真实环境中无缝复现人类动作。不仅如此,为了适应机器人的工作特性,团队还针对速度和运动舒适区进行了智能调整,确保机器人在执行任务时的安全与稳定。这一创新框架的问世,意味着机器人将能够通过模仿人类的自然动作,实现更高效、更智能的技能学习,为未来人机协作的广泛应用奠定了坚实基础。

github:https://github.com/michaelyuancb/motiontrans

划重点:

🦾 研究团队推出 MotionTrans 框架,使机器人可以零样本学习新技能。

👾 通过 VR 设备收集人类手部动作数据,构建丰富的训练数据集。

🔧 人类动作数据被转化为机器人语言,实现更高效的技能转移。