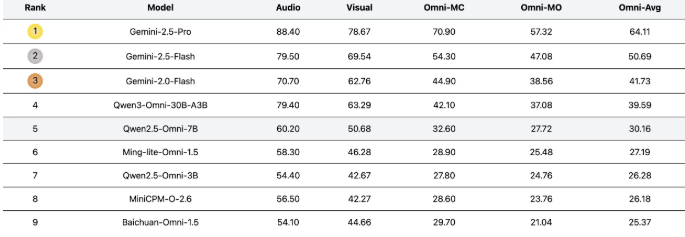

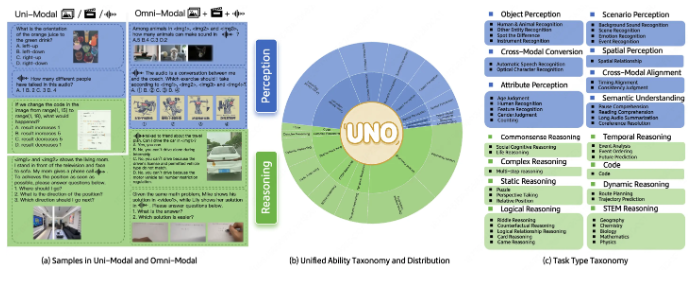

美团 LongCat 团队近日重磅推出全新基准测试平台 UNO-Bench,旨在全面评估多模态模型在不同场景下的综合理解能力。该基准测试覆盖了44种多样化任务类型,并融合了5种模态组合,为模型在单模态与全模态环境下的性能表现提供权威衡量标准。

UNO-Bench 的核心竞争力在于其构建的权威数据集。团队经过严格筛选,整合了1250个全模态样本,这些样本的跨模态可解性高达98%,确保了测试的精准性。此外,团队还补充了2480个经过专业增强的单模态样本,这些样本充分模拟真实应用场景,尤其在中文语境下的表现更为突出。特别值得一提的是,通过先进的自动压缩技术,这些数据集的运行效率提升了90%,同时保持了98%的测试一致性,在18个权威公开基准测试中表现卓越。

为了更科学地评估模型的复杂推理能力,UNO-Bench 创新性地引入了多步骤开放式问题模式。这种评估方式结合了智能评分模型,能够精准评估六种不同题型,准确率高达95%,为多模态模型的评测开辟了全新路径。这种突破性的评估机制,将极大推动多模态大语言模型评测体系的革新。

目前 UNO-Bench 主要面向中文场景应用,团队正积极寻求全球合作伙伴,计划未来推出英语及多语言版本。对多模态模型评测感兴趣的开发者,可通过 Hugging Face 平台免费获取 UNO-Bench 数据集,相关代码与项目文档也已在 GitHub 开源。随着 UNO-Bench 的正式发布,多模态大语言模型的评估标准将迎来重大升级,不仅为科研人员提供强大工具,更为整个AI行业的技术突破奠定坚实基础。

项目地址:https://meituan-longcat.github.io/UNO-Bench/