ICLR2025国际会议的审稿环节刚刚落下帷幕,一篇由苹果公司发布的、号称“小模型超越GPT-5”的视觉推理论文却遭遇了公开的学术“审判”。这一事件迅速在学术界掀起波澜,引发了对数据质量与科研诚信的深刻反思。

阶跃星辰的研究员Lei Yang在尝试复现该论文实验时,发现了一个令人震惊的问题:官方提供的代码中竟然遗漏了图片输入的关键步骤。当Lei Yang修复这一漏洞后,模型的准确率非但没有提升,反而出现了断崖式下跌。更令人担忧的是,在随机抽查的20道测试题中,竟然有6道的Ground Truth标签存在错误——这一比例意味着整体数据集的Ground Truth错误率可能高达30%。

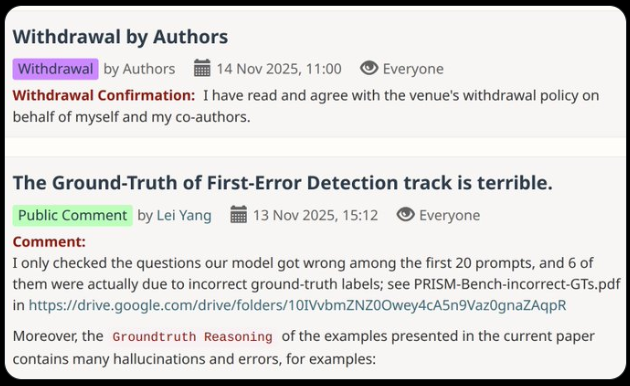

面对这一严峻问题,Lei Yang在GitHub平台上提交了详细的issue报告,然而却只收到了两句敷衍的回复,问题很快就被关闭。无奈之下,Lei Yang决定撰写一篇长文,向论文的审稿人及学术界发出警告。这一举动迅速引发了广泛关注,相关讨论在学术圈内迅速发酵。

事件发酵第二天,论文作者团队终于承认了“数据生成流程存在缺陷”,并紧急上传了修正版的基准数据集,同时承诺将重新运行实验、更新研究结果。这一回应虽然来得有些迟,但总算为事件画上了一个暂时的句号。

这一事件不仅暴露了大型科技公司科研过程中可能存在的漏洞,更引发了学术界对于数据质量控制的深刻思考。大模型时代,自动生成的数据集如果缺乏严格的人工质检环节,即便是像苹果这样的科技巨头也难免会“翻车”。Lei Yang的这一经历也给所有科研工作者敲响了警钟:“在复现任何实验之前,都应该先进行小样本的‘体检’测试,避免让错误的Ground Truth标签浪费宝贵的算力资源和科研时间。”

这一事件也提醒我们,在追求技术突破的同时,更不能忽视数据质量这一基础环节。只有建立完善的数据质量控制体系,才能确保科研工作的严谨性和可靠性,推动人工智能技术的健康发展。