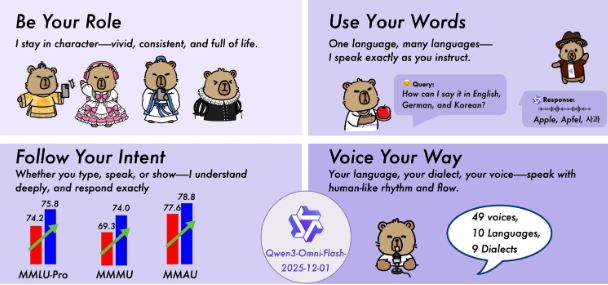

阿里通义 Qwen 团队近日正式发布了备受期待的 Qwen3-Omni-Flash-2025-12-01 版本,这一全新升级版基于强大的 Qwen3-Omni 模型架构打造,作为新一代原生全模态大模型,它能够无缝处理文本、图像、音频和视频等多种输入形式,并实现实时流式响应,生成既符合逻辑的文本内容又兼具自然韵律的语音输出。此次升级的核心突破主要体现在音视频交互体验的全面革新上。新版本通过深度优化算法,显著提升了对音视频指令的理解和执行能力,尤其针对口语化场景中常见的“降智”问题进行了专项攻克,使得多轮音视频对话的稳定性和连贯性大幅增强,让整个人机交互过程更加贴近真实对话场景,自然流畅度得到质的飞跃。

在系统提示控制方面,新版本实现了革命性的飞跃。用户现在可以全面自定义 System Prompt,对模型的行为进行精细到毫秒级的调控。无论是需要塑造特定的角色风格、调整口语表达偏好,还是设定回复的长度和结构,用户都能通过直观的界面精准实现,极大地提升了模型的可控性和个性化程度。在多语言处理能力上,Qwen3-Omni-Flash-2025-12-01 版本更是实现了跨越式发展,全面支持 119 种文本语言、19 种语音识别语言和 10 种语音合成语言,并且相较于前代产品,在语言遵循的稳定性上进行了全面优化,确保在各种跨语言场景下都能提供准确、一致的响应。特别是在语音生成方面,新版本的表现更加拟人化和流畅,有效解决了以往版本中存在的语速拖沓和机械感问题,模型能够根据文本内容自适应调整语速、停顿和韵律,使得语音输出效果更接近真实人类的对话状态。

在客观性能指标方面,Qwen3-Omni-Flash-2025-12-01 版本的全模态能力得到了全方位的显著提升。无论是文本理解与生成的深度、语音理解的精准度,还是语音生成的自然度以及图像理解的广度,均大幅超越了之前版本的表现,为用户带来了前所未有的自然、精准且生动的 AI 交互体验。这一系列突破性进展标志着大模型技术进入了新的发展阶段,为各行各业的应用创新提供了强大的技术支撑。划重点:🌟 新版本 Qwen3-Omni-Flash 通过全面升级音视频交互体验,显著增强了模型对音视频指令的理解与执行能力,让对话更加智能自然。 🌍 系统提示自定义功能全面开放,用户可以精细调控模型行为,实现高度个性化的交互体验。 💬 多语言支持能力得到优化,确保跨语言场景下响应的准确性与一致性,满足全球化应用需求。