近日,清华大学TSAIL实验室携手生数科技正式宣布开源革命性视频生成加速框架TurboDiffusion,这一里程碑式技术将AI视频扩散模型的推理速度实现了100至200倍的惊人飞跃,同时视觉质量几乎保持无损,标志着AI视频创作正式迈入实时生成的新纪元。

加速性能突破性提升:从分钟级到秒级生成

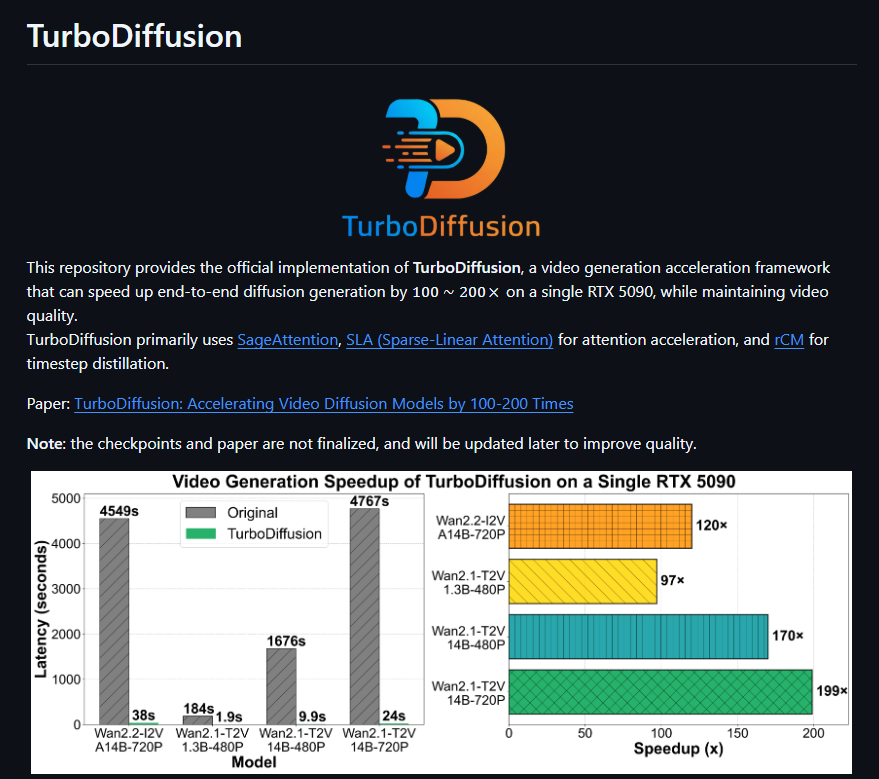

TurboDiffusion针对现有开源视频生成模型(如Wan2.1和Wan2.2系列的1.3B至14B参数模型)进行了深度优化,展现出惊人的加速性能。在单张RTX5090显卡上,端到端生成速度可达峰值200倍以上。具体表现如下:

– 5秒长视频生成时间从184秒锐减至1.9秒(约97倍加速)

– 高分辨率720P视频在14B模型下,生成时间从数千秒降至数十秒

即使在消费级RTX4090显卡上,也能流畅运行大型模型,无需依赖昂贵的A100或H100专业卡。这一突破大幅降低了AI视频生成的硬件门槛,让更多开发者和创作者能够轻松上手。

核心技术揭秘:多重优化组合拳

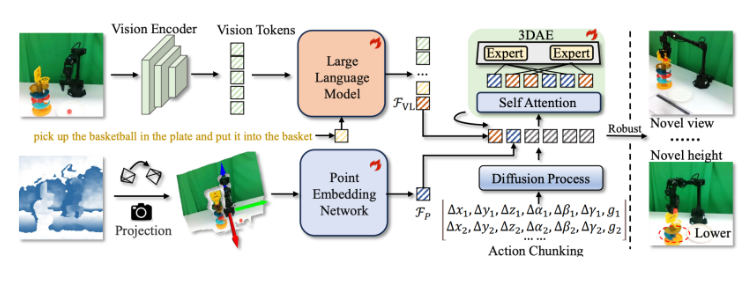

TurboDiffusion并非全新模型,而是一个高效推理框架,通过系统性创新实现近乎无损的加速。其核心技术包括:

– 8位量化:采用SageAttention实现低比特注意力计算,并利用Tensor Core加速

– 稀疏线性注意力(SLA):仅保留关键注意力连接,进一步减少计算量

– 时间步蒸馏(rCM):将传统上百步采样压缩至3-4步,结合分数正则化连续时间一致性蒸馏,确保质量稳定

这些技术正交结合,仅需6步训练流程即可复现,极大提升了可操作性。项目完全开源,包括代码、预训练模型权重以及完整训练脚本,已在GitHub上获得广泛关注。

行业影响深远:开启实时AI视频新纪元

TurboDiffusion的发布被业内视为视频生成领域的“DeepSeek时刻”,不仅解决了高分辨率、长时序视频生成的延迟与成本痛点,还吸引了Meta、OpenAI等国际团队的注意。该框架推动AI视频从实验阶段向规模化应用转型,未来有望支持交互式创作、企业级批量生产等场景。AIbase认为,这一开源项目将加速AI视频工具的普及,彻底改变内容创作格局。

感兴趣的开发者可立即访问GitHub仓库(https://github.com/thu-ml/TurboDiffusion)体验这一突破性技术。