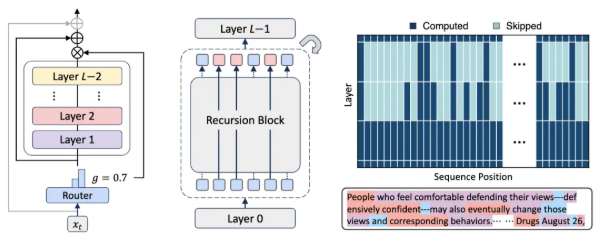

在人工智能技术的飞速发展中,大型语言模型(LLM)凭借其卓越的自然语言处理能力成为研究热点,然而高昂的计算和内存需求限制了其在实际场景中的应用。为了破解这一技术瓶颈,谷歌 DeepMind 创新性地提出了 Mixture-of-Recursions(MoR)架构,这一突破性设计有望颠覆传统 Transformer 模型的主导地位。MoR 架构在递归 Transformer 的基础上实现了革命性升级,通过参数共享与自适应计算的双重优化,在保持高性能的同时大幅降低资源消耗。其核心创新在于将动态 token 级路由机制无缝集成到递归 Transformer 中,使每个语言单元都能获得与其复杂度相匹配的计算资源,从而在不增加模型参数的前提下,实现与巨型模型相当的处理能力。

MoR 架构的轻量级路由系统堪称智能计算典范,该系统能够实时评估每个 token 的语义需求,为其分配最合适的递归深度,这种动态计算分配机制显著提升了资源利用率。在技术实现层面,MoR 采用了一种突破性的缓存策略,通过智能识别 token 的递归层级,选择性存储和调用相关的键值对信息。这一设计不仅有效缓解了内存带宽压力,更大幅提升了推理效率。通过参数共享、计算路由和递归级缓存等协同优化措施,MoR 模型在保持高性能的同时,参数数量大幅缩减,计算成本显著降低。

实验结果表明,MoR 架构在相同计算预算下展现出惊人的性能优势。与原始 Transformer 和递归 Transformer 相比,MoR 在参数量减少近50%的情况下,依然实现了更出色的表现。特别是在少样本学习任务中,MoR 模型的平均准确率超越了所有基线模型,这一成就充分证明其高效的计算策略能够处理更多训练数据。值得注意的是,MoR 在不同计算预算下的持续优异表现令人瞩目,当模型规模超过360M参数时,MoR 不仅能够与原始 Transformer 并驾齐驱,在低至中等预算条件下甚至能实现超越。这些实验结果充分验证了 MoR 架构的可扩展性和高效性,使其成为大规模预训练和部署的理想选择。

MoR 架构的推出为人工智能领域带来了突破性进展,其创新的计算范式预示着大型语言模型高效化发展新方向。这一技术突破不仅解决了传统模型的资源瓶颈问题,更为 AI 研究开辟了新的可能性。随着人工智能技术的不断演进,MoR 架构有望成为未来大型语言模型发展的新标杆,为自然语言处理技术的广泛应用奠定坚实基础。论文链接: alphaxiv.org/abs/2507.10524

? MoR 架构通过动态分配计算资源和缓存机制,有效提高大型语言模型的效率

? 在相同计算预算下,MoR 以更少参数超越传统 Transformer,性能更优

? MoR 被视为 AI 研究中的新突破,适合大规模预训练与部署