智谱今日正式宣布并开源其专业级 OCR 模型 GLM-OCR,这一创新成果以仅0.9B的轻量化尺寸实现了跨级性能突破,在多项权威基准测试中表现卓越,成功登顶行业榜单,致力于解决复杂文档解析中的真实业务挑战。

核心性能:小尺寸下的 SOTA 表现

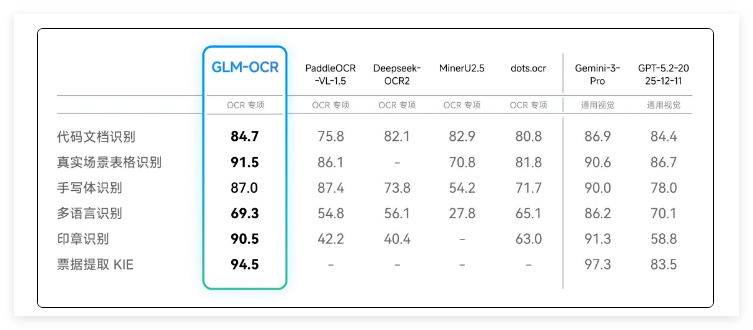

尽管参数规模仅为0.9B,GLM-OCR 的性能却令人惊叹。在权威文档解析榜单 OmniDocBench V1.5 中,该模型以高达94.6分的优异成绩夺冠,其性能已接近通用大模型 Gemini-3-Pro。无论是在文本识别、数学公式推导、复杂表格解析,还是关键信息抽取(KIE)方面,GLM-OCR 均取得了 SOTA(行业最顶尖)表现,展现了其在文档处理领域的强大能力。

场景突破:直击复杂文档痛点

GLM-OCR 针对六大高难业务场景进行了专项优化,表现稳健。在复杂表格处理方面,它支持合并单元格与多层表头,可直接输出标准 HTML 代码,满足多样化的数据展示需求。结构化提取方面,模型能智能识别卡证票据,并输出标准 JSON 格式,为数据自动化处理提供高效解决方案。此外,GLM-OCR 完美兼容教育科研中的手写公式及程序员的代码截图,在手写体与代码识别领域表现出色。特殊标识方面,它具备极高的印章识别能力,并能有效处理多语言混排的文档,展现出强大的语言适应性。

极致效率:推理更快,成本更低

在效率与成本控制方面,GLM-OCR 展现了极强的商业竞争力。其极速推理能力使 PDF 处理吞吐量达到1.86页/秒,显著优于同类模型。同时,模型支持 vLLM、Ollama 等主流部署方式,为用户提供了灵活的部署选择。极致性价比方面,API 价格低至0.2元/百万 Tokens,相比传统 OCR 方案,成本仅为后者的1/10。处理一千张 A4扫描件仅需约0.5元,为用户带来了显著的经济效益。

技术揭秘:多模态架构与强化学习

GLM-OCR 继承自 GLM-V 系列架构,并集成了自研 CogViT 视觉编码器。通过引入多 Tokens 预测损失(MTP)与全任务强化学习,模型在复杂版面下的泛化能力得到显著提升。其独特的4倍下采样策略与 SwiGLU 机制,确保了视觉信息与语言解码器的高效融合,进一步增强了模型的处理能力。目前,GLM-OCR 已在 GitHub 和 Hugging Face 同步开源,用户可自由获取并应用于各类场景。同时,智谱开放平台也已上线相关 API 及优惠包,为开发者提供了便捷的接入方式。