近日,中山大学、鹏城实验室与美团联合发布了一项突破性的图像分割多模态大模型——X-SAM,这一创新成果标志着图像分割技术迈入了一个全新的时代。X-SAM不仅显著提升了图像分割的精度,更实现了从“通用分割”到“任意分割”的历史性跨越,为视觉领域带来了革命性的变革。

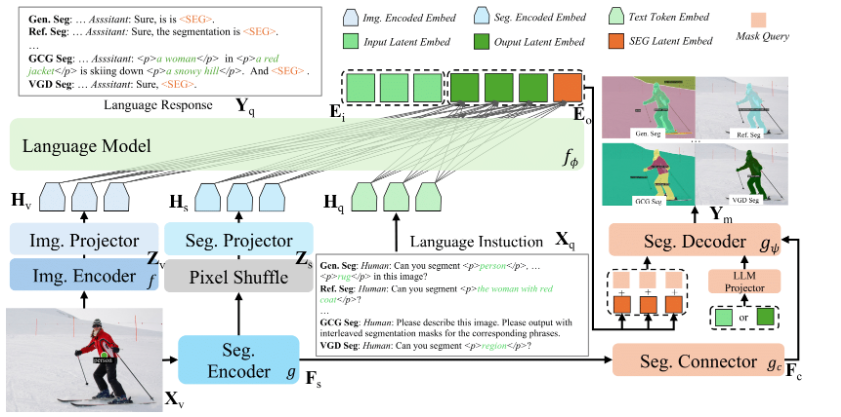

X-SAM的核心突破在于其创新的设计理念。首先,模型引入了统一的输入和输出格式,完美适配多样化的分割需求。用户可以通过文本查询或视觉查询两种方式进行操作:文本查询适用于各类通用分割任务,而视觉查询则支持通过点击、涂鸦等直观的视觉提示实现交互式分割,极大地提升了用户体验。此外,X-SAM的输出采用统一的表示方式,使得分割结果更加清晰易懂,便于后续应用。

为了进一步提升分割效果,X-SAM采用了双编码器架构。其中一个编码器专注于提取全局特征,另一个则深入关注细粒度特征,这种协同设计显著增强了模型的图像理解能力,确保了分割结果的精细度。同时,模型还创新性地引入了分割连接器和统一分割解码器,前者能够高效处理多尺度特征,后者则彻底革新了传统的解码器架构,进一步优化了分割性能。

X-SAM的训练过程经过精心设计,分为三个关键阶段。第一阶段为分割器微调,旨在全面提升模型的基础分割能力;第二阶段进行对齐预训练,确保语言与视觉的嵌入能够精准对齐;第三阶段则是混合微调,通过在多个数据集上进行协同训练,全面优化模型的整体性能。经过严格测试,X-SAM在20多个分割数据集上均达到了最先进的性能,充分展现了其卓越的多模态视觉理解能力。

随着X-SAM的成功问世,研究团队已规划将其应用扩展至视频领域。通过结合时间信息,X-SAM有望推动视频理解技术的快速发展,为构建更为智能的视觉系统开辟无限可能。这一新型模型的成功不仅为图像分割研究开辟了全新的方向,更为构建通用视觉理解系统奠定了坚实的基础。

代码地址:https://github.com/wanghao9610/X-SAMDemo地址: https://47.115.200.157:7861

划重点:? X-SAM模型实现了从“分割万物”到“任意分割”的重大飞跃,显著提升了图像分割的精度和应用范围。 ? 该模型引入统一输入输出格式,支持文本和视觉查询,大幅提升用户交互体验。 ? 经过三阶段训练,X-SAM在20多个数据集上达到了最先进性能,为未来的视觉理解系统奠定坚实基础。