团队计划部署智能客服系统,预算有限且主要服务中文场景,偶尔需要图像识别功能——是选择豆包1.5还是GPT-5-min?个人开发者希望借助大模型API开发写作助手,要求响应迅速且成本可控,Claude Haiku、Moonshot、GPT-5-min哪个更经济?这类涉及价格、语言、应用场景的选型难题,单纯依靠厂商宣传或零散评测难以解决。当技术决策者面对数十种参数各异的AI模型时,真正的困境并非”不知道”,而是”如何快速锁定既满足业务需求又符合预算的方案”。AIBase模型对比平台(https://model.aibase.cn/compare)正是为此量身打造——摒弃学术参数堆砌,专注真实场景下的决策支持。

一、为何真实场景对比比参数表更实用?大模型选型绝非简单比拼跑分。忽视以下关键因素,轻则预算超支,重则项目失败:中文理解能力:英文模型在中文场景可能表现不佳长文本计费规则:部分模型低量级便宜,长文本却价格飙升图像推理成本:按Token计费与按张计费差异巨大响应速度:实时交互场景下延迟直接影响体验生态适配:是否需要额外部署?是否支持API流式输出?AIBase模型对比平台的核心价值,在于将抽象参数转化为可落地的决策依据。

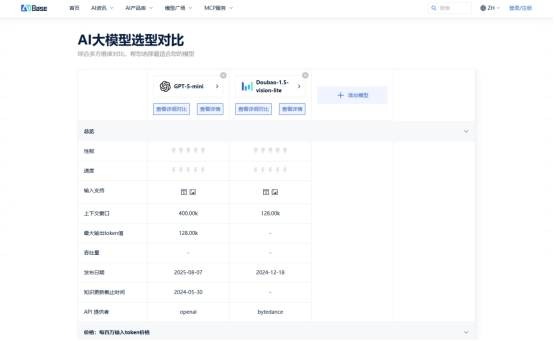

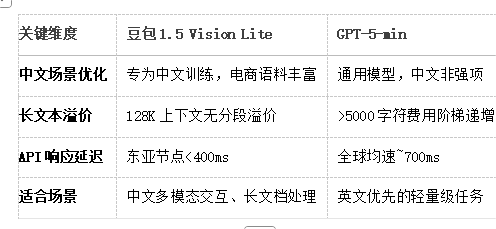

二、真实案例对比:豆包1.5Vision Lite与GPT-5-min谁更优?假设你正在为电商客服中台选择模型,需求明确:✅ 强中文支持 ✅ 多模态(能读商品图) ✅ 高性价比 ✅ 稳定API接入在AIBase平台只需三步操作:筛选条件:勾选”中文”、”多模态”、”支持API”加入对比:选择「豆包1.5Vision Lite」和「GPT-5-min」关键维度:聚焦下表红框指标结论清晰浮现:若业务以中文图文交互为主,豆包1.5在成本控制、语言适配、长文本处理上优势明显;若需求是轻量英文文本生成,GPT-5-min的全球化部署更具普适性。

三、AIBase对比平台的正确使用方法1.聚焦关键指标,拒绝参数轰炸隐藏晦涩的学术指标(如MMLU分数),突出价格、语言支持、上下文长度、API速率、多模态成本等业务级参数支持按场景筛选:勾选”中文优化”、”开源可商用”、”低延迟”、”图像/音频支持”等标签,快速过滤无关信息2.成本透明化,杜绝隐藏费用直接标注每百万Token输入/输出价格(如:Moonshot输入¥0.5/百万Token)揭露长文本溢价规则(如:GPT-5-min超过5000字符单价上升30%)明示多模态附加费(如:Gemini Vision图文混合请求按总Token计费)3.一键导出对比报告,助力团队决策选择3-5个候选模型,生成PDF对比报告,含官网链接与测试时间戳分享链接给技术伙伴,同步查看实时数据(例:豆包1.5vs GPT-5-min vs Claude3Haiku对比页)

四、谁正在用这个工具节省数小时工作?技术总监:快速筛选符合预算的API方案,输出对比报告说服管理层产品经理:根据”对话式AI”场景过滤模型,找到支持长上下文且低延迟的选项个人开发者:按”免费额度”排序,发现新上线Llama3400B API仍提供500万Token试用企业采购:验证厂商报价是否合理,避免为品牌溢价买单

五、让模型选型回归业务本质在AIBase模型对比平台,没有绝对”最好”的模型,只有”最适合当前需求”的选择。要低成本处理中文长文档?参考豆包、Kimi、DeepSeek的”上下文性价比”排序需高精度图像分析?对比GPT-4V、Gemini1.5Pro、Claude3Opus的多模态细节求极速响应?按”API延迟”筛选,发现Moonshot、Claude Haiku等黑马告别在厂商文档中反复切换,避免为隐藏成本埋单访问→AIBase 模型对比平台AIbase基地 – 让更多人看到未来 通往AGI之路用10分钟对比,省下100小时试错——让每一分算力预算都花在刀刃上。