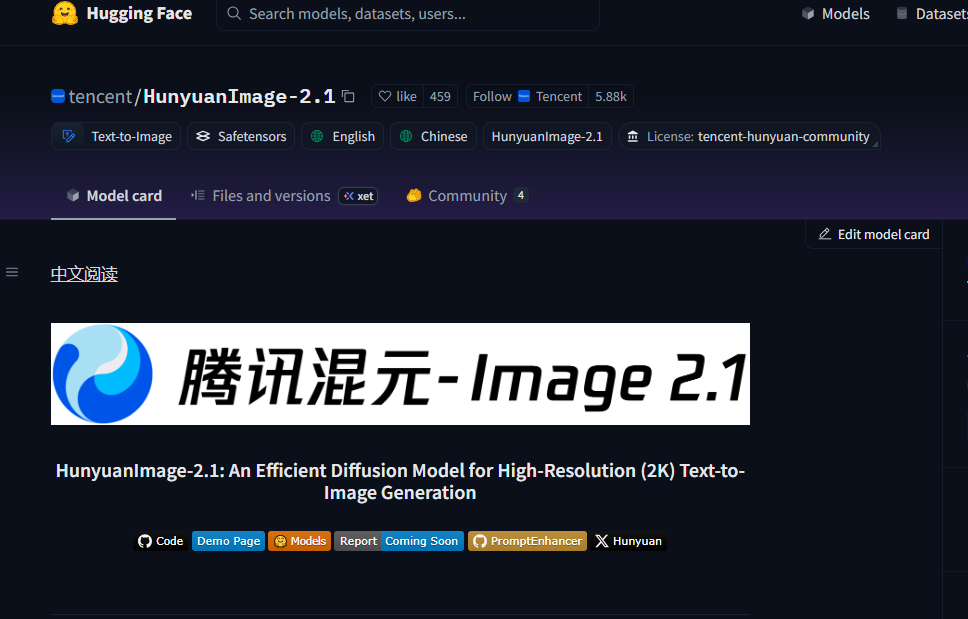

腾讯混元团队近日宣布正式开源其先进的文本到图像生成模型HunyuanImage2.1,这一突破性成果标志着开源AI在高分辨率创作领域迈出了重要一步。该模型能够原生输出2K(2048×2048)分辨率的图像,为AI驱动的视觉内容创作提供了前所未有的清晰度和细节。HunyuanImage2.1已在Hugging Face和GitHub平台全面开放,开发者可以无缝集成并利用其强大功能。

HunyuanImage2.1通过海量数据集训练和多专家模型优化,显著提升了文本与图像的对齐能力。其生成速度与1K图像相当,却能输出更高质量的视觉效果,预计将极大推动AI在设计、广告和内容创作领域的应用。核心功能升级方面,原生2K与复杂提示支持成为该模型的亮点。用户只需输入文本提示,即可获得细节丰富、语义一致的2K高清图像。模型支持最长1000token的复杂提示词,能够精准控制图像中多个主体的姿势、表情和场景布局,有效避免传统AI常见的漂移问题。

以”一个穿着古装的男子在夕阳下骑马,旁边伴随一位舞剑女子”为例,HunyuanImage2.1能生成高度协调的多主体画面,完美适用于插画、海报或封面设计。模型还原生支持中英文混合提示词,并内置提示词增强机制,进一步提升生成结果的一致性和创意性。在跨场景泛化能力上,该模型表现出色,能够处理物理规律、三维空间等复杂语境,确保图像的真实感和美观度。

文本嵌入与多场景应用是HunyuanImage2.1的另一大优势。用户可以指定文字的字体、位置和风格,实现专业级视觉效果,如生成带有标题的书籍封面、宣传海报或社交媒体插图。这种功能特别适合商业设计场景,帮助创作者快速迭代内容,而无需借助额外编辑工具。模型优化了生成效率,2K图像的处理时间与1K相当,仅需数秒即可完成,显著降低计算资源消耗。这使得它在资源受限的环境中也能高效运行,适用于移动端和云部署场景。

在专业评估中,HunyuanImage2.1作为开源模型,与闭源Seedream3.0的胜率接近(-1.36%),并在开源阵营中超越Qwen-Image(+2.89%),在语义对齐、细节控制和多对象生成上均获高分。超过100位专业评估者参与测试,证实其图像质量已达商业级水准。腾讯强调,这一开源举措旨在推动AI生态发展,模型权重和代码已全面公开,支持自定义微调。相比前代HunyuanImage2.0,该版本在分辨率和控制精度上实现质的飞跃,有望成为设计师的首选工具。

HunyuanImage2.1的发布进一步巩固了腾讯在开源AI图像生成领域的领先地位,预计将吸引全球开发者涌入Hugging Face社区进行集成与创新。该模型的高性能和开放性将为AI设计工具市场带来新的活力,加速AI在设计、广告和内容创作领域的商业化进程。地址:https://huggingface.co/tencent/HunyuanImage-2.1