随着人工智能技术的飞速发展,开发能够独立完成复杂任务的大规模语言模型(LLM)代理已成为学术界和工业界的焦点。为了让这些代理具备类似人类的智能,能够通过探索和与环境互动来学习,研究者们迫切需要一个强大而统一的强化学习(RL)框架。然而,当前的研究仍面临重大挑战——缺乏一种有效的训练方法,能够在多样化的真实环境中,从零开始训练代理,且不依赖于监督微调(SFT)。为攻克这一难题,字节跳动Seed研究团队创新性地推出了名为 AgentGym-RL 的新框架,专注于通过强化学习训练 LLM 代理,使其能够进行多轮互动决策。

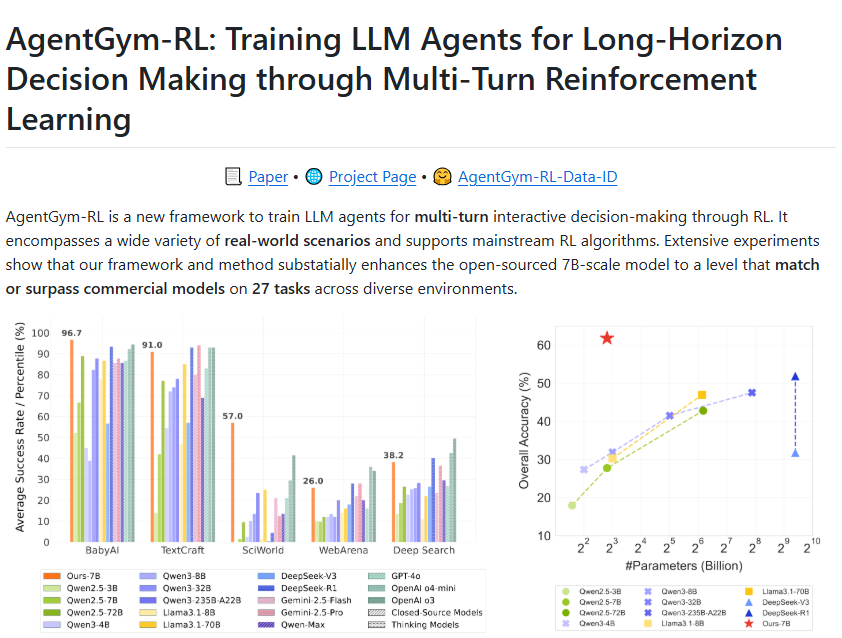

AgentGym-RL 框架采用模块化和解耦的架构设计,赋予了极高的灵活性和扩展性,能够适应不同场景下的训练需求。该框架覆盖了多种真实场景,包括网络导航、深度搜索、数字游戏、体感任务和科学实验等,要求代理在这些复杂环境中展现出强大的决策能力和适应能力。此外,AgentGym-RL 还支持主流的强化学习算法,为代理全面提升决策能力提供了强大的技术支撑。

为进一步优化训练效果,研究团队还提出了一种名为 ScalingInter-RL 的创新训练方法。该方法通过阶段性调整交互次数,帮助代理在早期阶段专注于掌握基本技能,随后逐渐增加交互次数,以鼓励更多样化的问题解决策略。这种探索与利用的平衡设计,有效提升了代理在面对复杂任务时的学习和决策稳定性。

在实验验证阶段,研究者们选取了 Qwen2.5-3B 和 Qwen2.5-7B 作为基础模型,在五个不同场景中评估了 AgentGym-RL 和 ScalingInter-RL 的表现。结果显示,使用 AgentGym-RL 的代理在27个任务中表现优异,超越了多个商业模型,展现出与顶尖专有大模型相当的能力。这一成果充分证明了 AgentGym-RL 框架的强大效能和广泛适用性。

展望未来,研究团队计划将整个 AgentGym-RL 框架,包括代码和数据集,完全开源,以支持更多研究者开发智能代理,推动人工智能领域的创新与发展。这一举措将极大地降低智能代理开发的门槛,加速相关技术的普及和应用。

项目官网:https://agentgym-rl.github.io/

划重点:

🌐 AgentGym-RL 框架提供了一种创新方法,通过强化学习训练大规模语言模型代理,显著提升其复杂任务的决策能力。

🔄 ScalingInter-RL 训练方法通过阶段性调整交互次数,实现有效的探索与利用平衡,优化代理的学习效率。

🏆 实验结果表明,AgentGym-RL 框架大幅提升了代理的表现,超越多个商业模型,具备与顶尖专有大模型相当的性能。