微新创想

2月13日的消息显示,国产AI领域最近迎来了一波重大更新。在前几天,智谱GLM-5、Minimax 2.5以及DeepSeek相继发布了新一代大模型,其中DeepSeek的更新引发了广泛关注。此次更新的核心在于显著提升了模型的上下文处理能力,达到了1M的长度,而此前的DeepSeek V3系列仅支持128K。这一提升意味着在处理长文本或进行复杂对话时,模型能够更好地理解和记忆上下文内容,从而提高交互的连贯性和准确性。

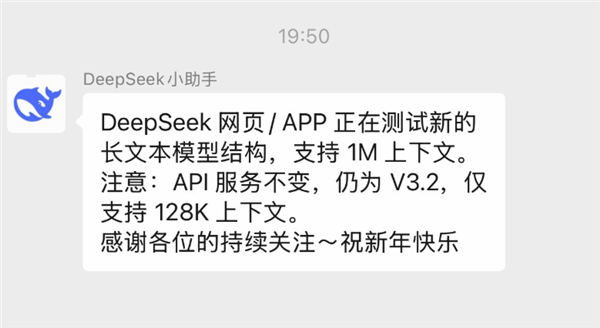

今晚DeepSeek在官方群中正式确认了这一更新。据透露,网页及APP版本正在测试新的长文本模型结构,支持1M上下文。同时,DeepSeek也明确表示,目前API服务仍基于V3.2系列大模型,仅支持128K上下文。这种区分表明,DeepSeek正在探索不同版本的模型架构,以满足不同场景下的需求。

从DeepSeek的官方介绍来看,此次更新主要集中在文本模型的优化上。提升的上下文能力在多个应用场景中都具有重要意义。例如,在进行长对话或处理大量文本信息时,模型能够更准确地捕捉用户意图,避免因上下文不足而产生的误解。这种能力的增强,无疑将为用户带来更流畅、更智能的体验。

尽管网上已有不少实测反馈,显示此次DeepSeek大模型在编程、输出速度等方面也有明显提升,但与此前的期待相比,这次更新仍显得有些不足。有分析认为,此次发布的大模型并非V4版本,更可能是V4 Lite。据内部消息透露,该模型的参数量仅为2000亿,远低于V3系列的6700亿。因此,部分性能指标相较于V3有所下降,这在一定程度上引发了用户的失望情绪。

DeepSeek官方并未详细说明此次V4 Lite的技术架构,这也让外界对其具体能力感到好奇。不过,从当前的更新来看,可以推测这一版本可能是为了探索未来大模型的可能方向而推出的试验性产品。未来,DeepSeek预计还会有更多版本发布,比如V4的满血版,参数量高达1.5万亿,这将是V3系列的两倍以上。此外,该版本将采用DeepSeek之前研究的Engram、mHC等新技术,进一步提升模型的性能,同时降低计算成本。

总体来看,DeepSeek此次更新虽然在上下文能力上实现了突破,但相较于外界对V4版本的期待,仍有提升空间。随着更多技术细节的公布,以及不同版本的逐步推出,DeepSeek有望在AI领域持续发力,为用户提供更优质的服务。