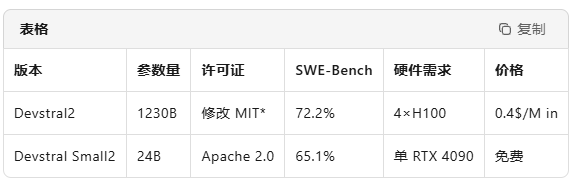

Mistral AI 正式推出第二代开源编码模型家族,包括参数量高达1230亿的旗舰版Devstral2与轻量级240亿参数的Devstral Small2。这一全新模型系列在开源领域引发重大突破,不仅性能大幅提升,还以极具竞争力的成本优势重新定义了开源AI工具的价值标准。

旗舰模型Devstral2在权威SWE-Bench Verified基准测试中取得72.2%的卓越成绩,刷新了开源代码模型的最佳纪录。该模型在性能表现上展现出惊人实力,超越CodeLlama-70B(53.8%)、DeepSeek-Coder-33B(61.4%)等主流开源模型,与GPT-4-Turbo(73.2%)的差距仅1个百分点。在HumanEval测试中,Devstral2同样表现优异,Pass@1指标达到84.1%,领先同类开源模型6-8个百分点。

成本效益方面,Mistral AI官方宣称Devstral2的”成本效益比Claude Sonnet低7倍”,单百万输入token仅需0.4美元,约为GPT-4-Turbo价格的五分之一。这一极具吸引力的定价策略,配合完全免费的轻量版模型,为开发者提供了前所未有的高性价比选择。

为提升开发体验,Mistral AI同步推出了自然语言批量代码重构工具Mistral Vibe。用户只需通过简单指令,例如”把函数改为异步”,即可自动重写整个代码仓库,并支持diff预览与回滚功能。该工具基于本地Devstral Small2(Apache2.0授权),无需联网即可运行,现已推出VS Code插件,可一键修复ESLint错误或添加单元测试。

在商业模式上,Mistral AI采用分层收割策略。轻量版Devstral Small2完全免费开放,支持商用、微调及嵌入,为开发者提供无限制的基础能力。旗舰版Devstral2采用修改版MIT授权,月营收超过200万美元的企业需购买商业许可或使用官方API,以此避免大型科技公司免费占用资源。

API服务方面,Devstral2每百万输入token定价0.4美元,输出成本为1.2美元,前30天提供100万token的免费额度。这一灵活的定价机制,既保证了商业可持续性,又为开发者提供了充足的试用空间。

Devstral AI的推出标志着开源编码模型进入”70+”俱乐部。2024年主流开源代码模型在SWE-Bench上的平均得分普遍停留在50-60%区间,而Devstral2直接将门槛提升至72%以上。低成本与高性能的完美结合,将有力冲击GitHub Copilot、Cursor等付费插件的性价比优势。完全免费的轻量版模型有望加速”本地AI编码助手”的普及,开发者只需配备RTX4090显卡即可运行24亿参数模型。

未来路线图方面,Mistral AI制定了清晰的发展规划。2025年第一季度将发布Devstral2-INT4量化版本,支持单A100 GPU即可运行;同时推出Jetson Orin边缘部署包。第二季度将开放128k上下文版本,支持将整个代码库及文档作为prompt输入。第三季度将上线”Vibe Cloud”服务,允许用户在浏览器中自然语言重构整包代码,并按项目计费。

当代码生成能力竞争进入70+分时代,胜负手已从单纯追求模型能力转向成本与合规性。Devstral2以0.4美元百万token的震撼价格打破价格壁垒,并通过修改MIT授权有效防止大厂白嫖。轻量版彻底开源的战略布局,则成功抢占本地部署心智。对于开发者而言,”免费24B+低价1230B”的组合意味着本地编写代码、云端处理复杂任务成为可能,无需再为Copilot订阅付费。AIbase将持续关注其量化版本与128k长上下文功能的发布进展。