在大语言模型的激烈竞争中,数学推理能力已成为衡量模型优劣的关键指标。近日,快手科技推出了一款名为 Klear-Reasoner 的创新模型,该模型基于 Qwen3-8B-Base 架构打造,在多项权威基准测试中表现卓越,其数学推理准确率更是高达90%以上,一跃成为同规模模型中的佼佼者。这一突破性成果的背后,是 Klear-Reasoner 采用的 GPPO(Gradient-Preserving Clipping Policy Optimization)算法的巧妙设计。

GPPO 算法在确保训练过程稳定性的同时,显著增强了模型的探索能力。传统的裁剪策略虽然能有效控制模型更新幅度,防止训练过程中的剧烈波动,但往往会导致模型因”丢弃重要信息”而变得过于保守。GPPO 则以创新的方式,让所有梯度参与反向传播过程,既保留了模型探索新知识的机会,又大幅提升了模型对错误的修正效率。这种”温和”而高效的优化策略,为 Klear-Reasoner 的卓越表现奠定了坚实基础。

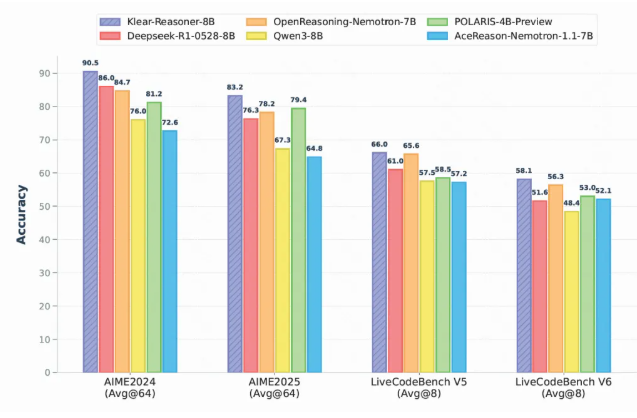

在各类基准测试中,Klear-Reasoner 均展现出超越同规模开源模型的强劲实力。特别是在 AIME2024 测试中,该模型以90.5%的优异成绩领跑全场;在 AIME2025 测试中同样表现不俗,取得了83.2%的卓越成绩。这些亮眼表现充分证明了 Klear-Reasoner 在数学推理领域的领先地位。

Klear 团队还详细分享了模型的训练秘诀,包括对数据质量的严格把控、在高难样本中保留错误策略的创新应用、以及使用软奖励机制提升学习效率等关键环节。其中,团队特别强调优质数据源的质量远比数量更重要。在监督微调(SFT)阶段,通过精准过滤错误数据并集中训练高质量样本,可以显著提升模型的训练效率。此外,团队发现软奖励策略在强化学习阶段比硬奖励机制更为有效,能够有效增强模型的学习稳定性。

Klear-Reasoner 的成功发布不仅彰显了快手科技在人工智能领域的深厚技术积累,更为推理模型的训练提供了一条可复现的优化路径。这一突破性成果为未来相关领域的研究和开发提供了宝贵的经验和启示,必将推动大语言模型在数学推理能力上迈上新台阶。

Klear-Reasoner 模型已在 Hugging Face 平台上线,用户可通过以下链接获取

https://huggingface.co/Suu/Klear-Reasoner-8B

完整代码及项目文档也已托管在 GitHub

https://github.com/suu990901/KlearReasoner/tree/main

? Klear-Reasoner 模型在数学推理准确率上突破90%,成为8B模型中的领军者

? GPPO 算法提升了模型的探索能力,解决了传统裁剪策略的隐性问题

? 关注数据质量和训练策略,Klear 团队的研究为推理模型提供了有效的训练方法