近日,约翰霍普金斯大学的研究团队隆重推出了一款创新的多语种编码器——mmBERT,旨在填补当前自然语言处理领域中多语种处理的空白。这款模型不仅在多项任务上超越了XLM-R的标杆性能,更在处理速度上实现了惊人的2至4倍提升,为多语种应用的研究与开发注入了强大的动力。

mmBERT的架构设计独具匠心,分为基础模型和小型模型两种配置。基础模型由22层变换器构成,隐藏层维度达到1152,总参数量约为3.07亿,而小型模型的参数量则精简至1.4亿,兼顾了性能与效率。在技术层面,mmBERT采用了先进的Gemma2分词器,支持高达256k的词汇量,并巧妙运用旋转位置嵌入(RoPE)和FlashAttention2技术,显著提升了处理效率。此外,该模型的序列长度从1024个令牌扩展至8192个令牌,使其能够处理更长的上下文信息,满足复杂应用场景的需求。

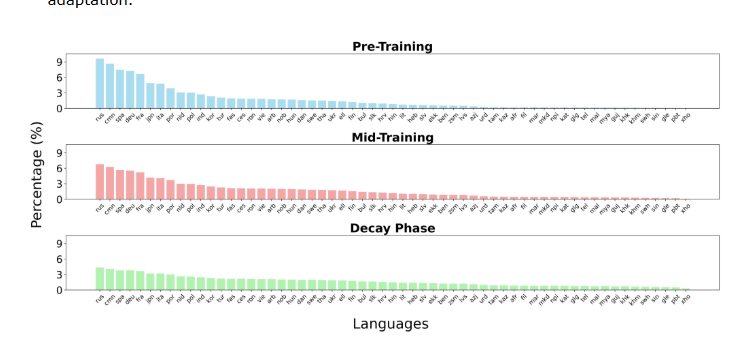

在训练数据方面,mmBERT展现了卓越的包容性。模型使用了来自多个来源的3万亿个令牌,覆盖了1833种语言,其中英语在整个语料库中仅占10%至34%。这种多元化的数据集确保了模型在全球范围内的普适性。训练过程分为三个阶段:预训练、阶段中训练和衰减阶段。在每个阶段中,模型逐步接触更多语言和更高质量的数据,这种渐进式训练方法有效提升了低资源语言的表现,为全球语言提供了更公平的展示平台。

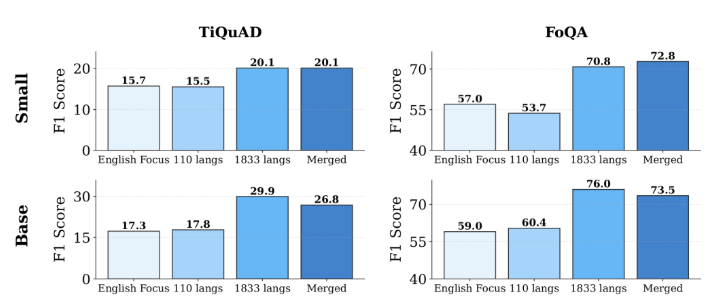

mmBERT在多个基准测试中交出了亮眼的成绩单。在英语自然语言理解(GLUE)任务中,基础模型的得分高达86.3,超越了XLM-R的83.3。在多语种自然语言理解(XTREME)任务中,mmBERT的得分同样领先,达到72.8,而XLM-R的得分则为70.4。此外,在嵌入任务和代码检索任务中,mmBERT也表现出色,彰显了其在多种应用场景中的巨大潜力。

特别值得一提的是,mmBERT对低资源语言的关注。在法罗语、提格雷尼亚语等低资源语言的基准测试中,mmBERT的表现均优于其他大型模型,证明了精心训练的编码器模型能够有效应对低资源场景的挑战。这一突破性成果为全球语言多样性保护提供了新的解决方案。

mmBERT不仅提升了多语种处理的速度和效率,更为下一代多语种自然语言处理系统奠定了坚实的基础。它以高效、开放的方式重新定义了多语种编码器的潜力,标志着自然语言处理领域进入了一个全新的时代。

github:https://github.com/JHU-CLSP/mmBERT?tab=readme-ov-file

划重点:

🌍 mmBERT模型在多个任务上超越了XLM-R,成为多语种NLP的新标杆。

⚡ 该模型速度提升2至4倍,支持处理高达8192个令牌的输入。

📊 mmBERT特别关注低资源语言的训练表现,展现出强大的适应能力和广泛应用潜力。