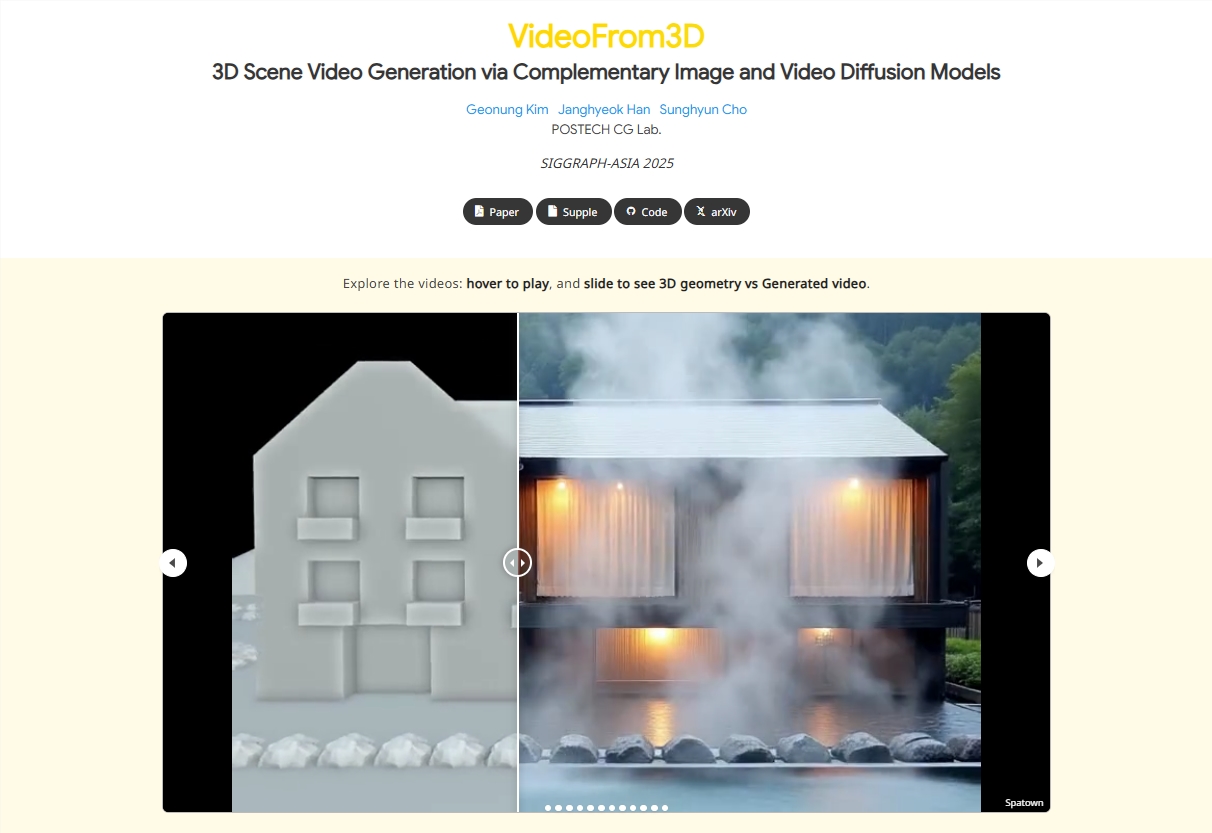

在人工智能赋能创意的浪潮中,一项革命性技术正悄然重塑3D图形设计的未来。最新问世的VideoFrom3D框架,通过创新性地融合图像与视频扩散模型,实现了从简陋几何形状、相机轨迹及参考图像到高度逼真且风格统一的3D场景视频的飞跃式生成。这一突破性进展摆脱了对昂贵配对3D数据集的依赖,极大简化了设计流程,使设计师与开发者能够以更高效的方式探索创意,并迅速将高质量成果付诸实践。

VideoFrom3D的核心奥秘在于其双模块协同架构:稀疏锚视图生成(SAG)模块与几何引导生成插帧(GGI)模块。SAG模块巧妙运用图像扩散模型,以参考图像和基础几何为蓝本,生成跨视角高度一致的锚视图,确保视觉细节与风格的完美统一。紧随其后,GGI模块借助视频扩散模型,在锚视图上无缝插值生成中间帧,通过流式相机控制与结构化引导,实现流畅的运动轨迹与时间维度上的高度一致性。这种设计精妙地规避了传统视频扩散模型在复杂场景中面临的视觉质量、运动建模和时间一致性的多重挑战。研究数据有力证明,该框架无需任何3D-自然图像配对数据,即可生成高保真视频,显著提升了内容生成的效率。

VideoFrom3D最引人注目的亮点在于其“零配对”策略,彻底颠覆了以往依赖海量标注数据的3D生成范式。该框架仅需输入基础几何(如简易网格或点云)、相机轨迹规划以及一张参考图像,便能自动合成完整的视频序列。这一创新不仅大幅降低了数据获取的门槛,更支持风格自由切换和多视角一致性,完美适用于从室内空间到户外景致的多样化应用场景。实验结果令人瞩目,VideoFrom3D在基准测试中超越了现有基线模型,尤其在复杂动态场景中表现卓越。生成视频的保真度达到了专业水准,运动轨迹自然流畅,风格保持高度统一,为3D图形设计注入了前所未有的“即插即用”活力。

VideoFrom3D框架的问世,将深刻变革3D图形设计、影视特效和虚拟现实等多个领域。设计师能够从草图快速迭代至成品视频,显著缩短生产周期;开发者则可轻松构建沉浸式场景,用于游戏原型或增强现实体验的开发。更为重要的是,这一技术推动了AI在创意工具中的民主化进程,使中小团队也能触达以往仅限于大型企业的尖端生成能力。

VideoFrom3D不仅是一个技术框架,更代表着3D内容生成范式的历史性转折点。它雄辩地证明了扩散模型在3D领域的无限潜能,预示着未来将涌现更多“从零到一”的颠覆性创新。项目地址:https://kimgeonung.github.io/VideoFrom3D/