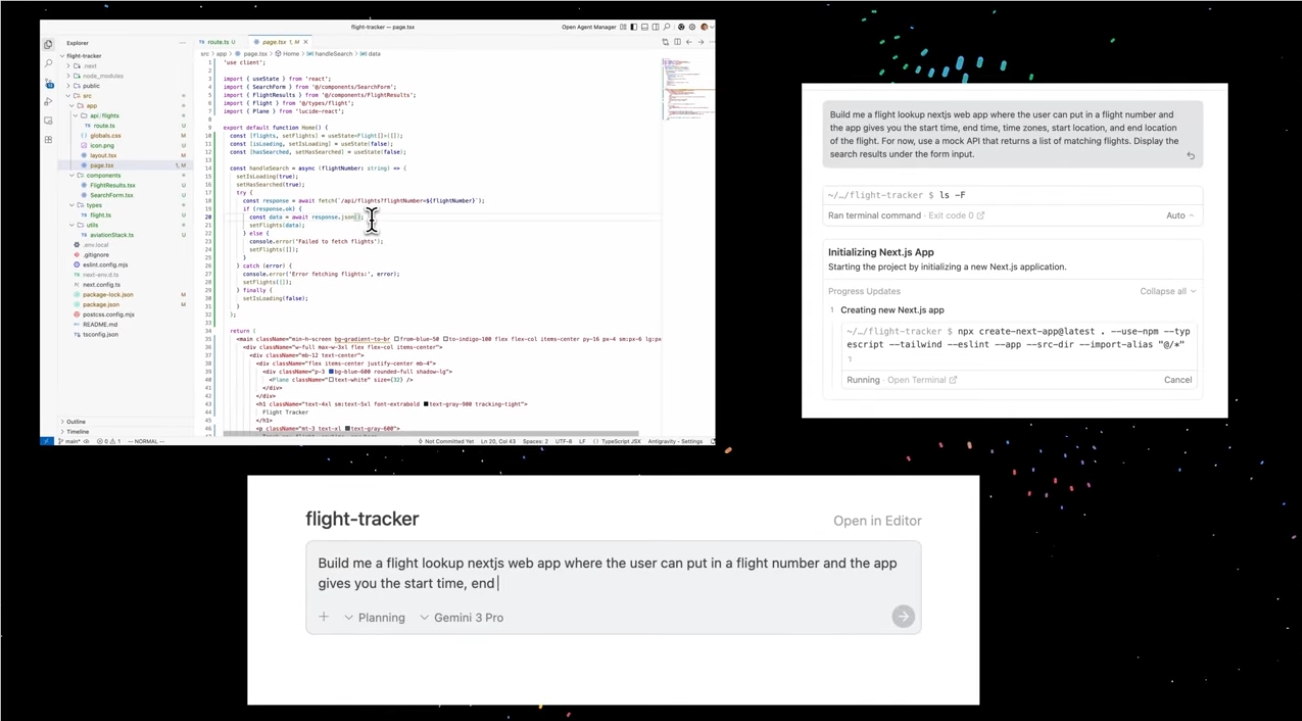

谷歌最新推出的基于 Gemini 人工智能的编程工具 Antigravity,在正式上线仅24小时后便遭遇重大安全危机。知名安全研究员亚伦・波特诺(Aaron Portnoy)在深入测试中发现了一个惊人的漏洞——通过简单修改 Antigravity 的配置参数,攻击者可以诱导 AI 执行恶意代码,从而在用户计算机中植入隐蔽的“后门”。这一漏洞不仅能够为攻击者提供远程访问权限,更可能被用于恶意软件安装、敏感数据窃取甚至勒索软件攻击等恶意行为。值得注意的是,该漏洞同时影响 Windows 和 Mac 操作系统,攻击者只需巧妙设计诱导用户运行特定代码,即可轻易获取系统控制权。

波特诺在研究报告中严厉指出,Antigravity 的安全漏洞暴露了企业在 AI 产品发布前缺乏严谨的安全测试流程。他强调:“AI系统在投入使用时承载着巨大的信任基础,但当前的安全边界防护却几乎形同虚设。”尽管波特诺已将详细漏洞报告提交给谷歌,但截至目前,谷歌尚未提供任何修复补丁。令人担忧的是,谷歌安全团队也承认在 Antigravity 代码编辑器中发现了另外两个高危漏洞,黑客同样可以利用这些漏洞非法访问用户计算机中的文件资料。

随着网络安全研究人员陆续公开披露 Antigravity 的多个安全缺陷,谷歌在产品发布前的安全准备不足引发了广泛质疑。多位网络安全专家指出,当前AI编程工具普遍存在技术架构陈旧、设计缺陷等问题,加之被赋予过高的数据访问权限,使其成为黑客重点攻击目标。在人工智能技术快速迭代的时代背景下,类似 Antigravity 的安全风险正成为行业普遍面临的挑战。波特诺特别呼吁谷歌在 Antigravity 执行用户代码时,应增设强制性安全警告机制,以切实保障用户权益。这一事件也再次提醒业界:在追求AI自动化能力的同时,必须构建更为完善的安全防护体系,避免技术被恶意利用。