硅基流动大模型服务平台近日正式推出蚂蚁集团百灵团队最新开源的 Ling-mini-2.0 模型,这一创新成果在保持卓越性能的同时,实现了令人瞩目的生成速度,标志着小体量模型大能量的技术突破。Ling-mini-2.0 采用先进的 MoE 架构,总参数量高达16B,但在实际生成过程中,每个 Token 仅需激活1.4B 的参数,这一设计巧妙地平衡了模型规模与运行效率,显著提升了生成速度。这种创新架构不仅确保了模型在处理任务时依然保持出色的性能表现,还使其能够与10B 以下的 Dense 语言模型以及其他更大规模的 MoE 模型进行有效对比,展现了极高的通用性和灵活性。

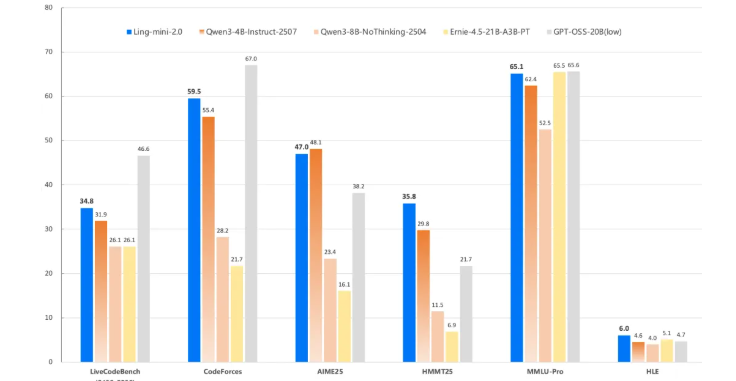

Ling-mini-2.0 的最大上下文长度支持高达128K,这一突破性设计极大地扩展了模型的适用范围,使其能够处理更复杂、更庞大的任务场景。在基准测试中,Ling-mini-2.0 在编码、数学以及知识密集型推理任务中均表现出色,取得了令人满意的成绩,充分彰显了其强大的综合推理能力。特别是在高难度任务中,该模型的性能更是超越了众多同类产品,展现出卓越的技术实力。

除了卓越的性能表现,Ling-mini-2.0 在生成速度上同样优势明显。在2000Token 以内的问答任务中,其生成速度可超过300个 Token 每秒,是传统8B Dense 模型的两倍以上。随着输出长度的增加,该模型的速度还能进一步提升,最高可达7倍的相对加速,为开发者提供了极高的效率保障。

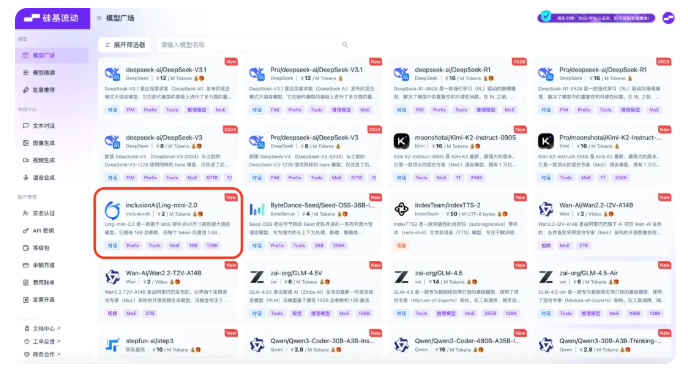

为了降低开发门槛,硅基流动平台为开发者提供了多种接入方案和详尽的API文档,支持在平台上进行模型的对比与组合,帮助开发者轻松实现生成式AI应用。平台内还内置了多款大模型API供开发者免费使用,进一步推动了AI技术的普及和应用,为创新提供了强大的技术支撑。

划重点:Ling-mini-2.0 总参数16B,每个 Token 仅激活1.4B 参数,实现高效生成;模型支持128K 最大上下文长度,展现出强大的推理能力;硅基流动平台提供多种接入方案,支持开发者轻松使用多款大模型API。