前OpenAI首席技术官Mira Murati创立的Thinking Machines Lab近日宣布一项革命性技术突破,成功攻克了困扰AI行业多年的模型输出不确定性难题。这份重磅研究成果在最新发布的研究报告中详细阐述,该实验室实现了大语言模型推理过程的完全确定性输出。

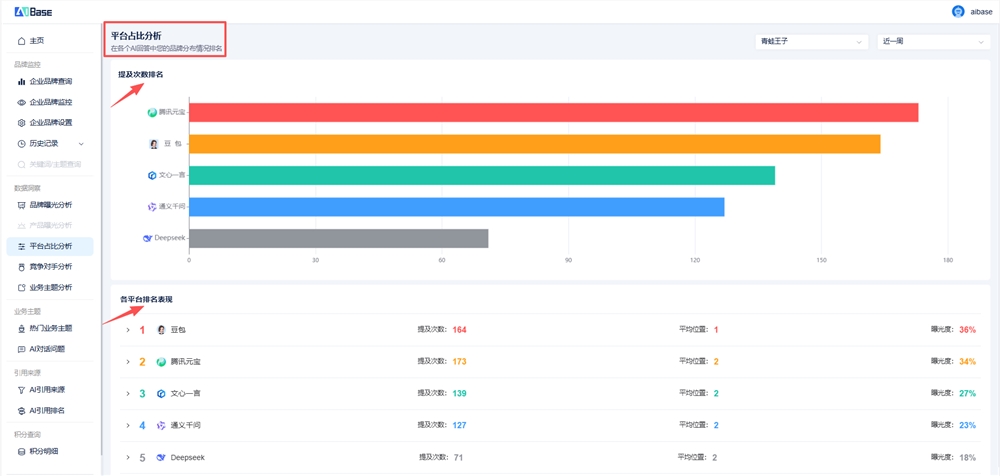

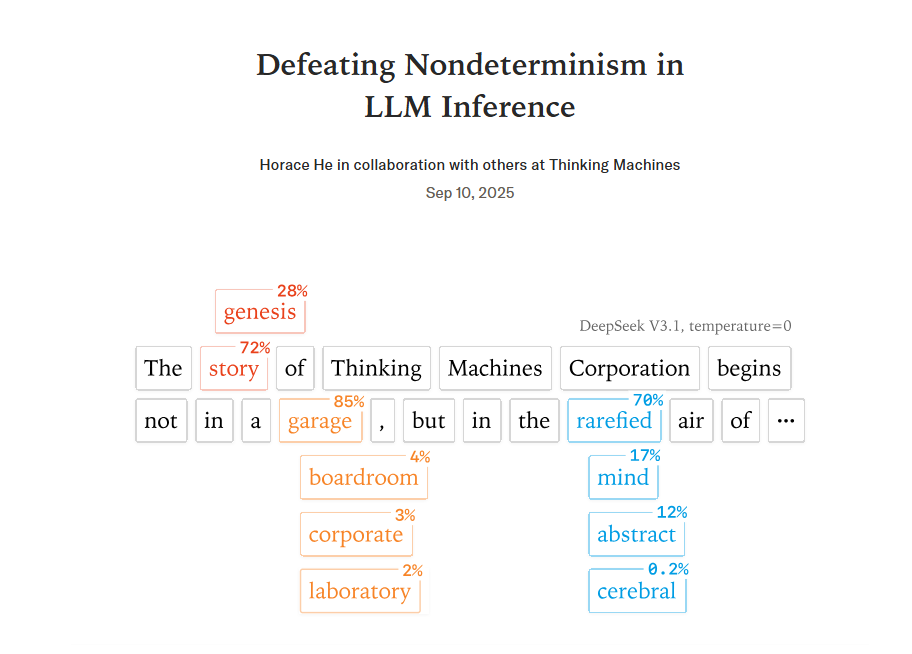

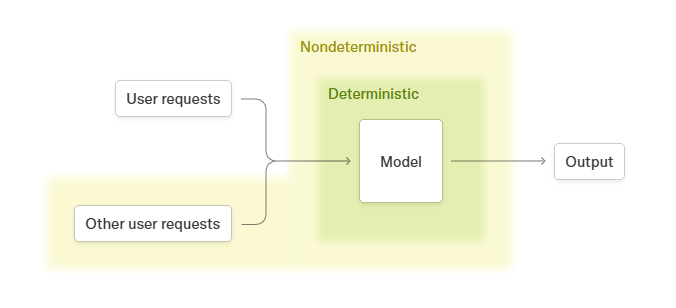

《在LLM推理中战胜不确定性》的研究报告揭示,即使在温度参数设为0的极端条件下,传统大语言模型仍会对相同输入产生截然不同的输出。研究团队通过深入分析,精准定位了导致这一现象的两大技术根源,并提出了创新性的解决方案。

研究发现,造成输出不确定性的第一个关键因素是浮点数加法的非结合性问题。在GPU并行计算环境中,(a + b) + c与a + (b + c)的计算结果可能存在微小差异,这些差异在复杂的神经网络中会逐层累积放大。更为核心的发现是,并行计算策略的动态变化才是导致输出不确定性的根本原因。不同的批量大小、序列长度以及KV缓存状态会改变GPU内核的选择策略,进而影响计算执行顺序,最终导致输出结果的差异。

针对这一技术挑战,Thinking Machines Lab创新性地提出了batch-invariant解决方案。该方案要求所有关键计算核在处理不同批量大小或序列分割时,必须保持完全一致的计算顺序和结果。研究团队还针对RMSNorm、矩阵乘法和注意力机制等核心计算模块,提供了具体的优化方法指南。

为验证技术方案的有效性,研究团队选用拥有2350亿参数的Qwen3-235B-A22B-Instruct-2507模型进行严格实验。经过1000次重复测试,该模型在相同输入条件下实现了100%的输出一致性,这一成就在大语言模型发展史上尚属首次突破。

业界专家普遍认为,这一技术突破对企业级AI应用具有里程碑式的意义。金融风控、医疗诊断、法律文书审核等对准确性和一致性要求极高的应用场景将直接受益于这项技术进步。Thinking Machines Lab此次选择以开放研究的形式发布成果,为全球AI开发者提供了宝贵的技术参考方向。该研究不仅解决了模型输出的可预测性问题,更为AI系统从实验工具向生产工具的转型奠定了坚实的技术基础。

据了解,Thinking Machines Lab成立于2023年,专注于AI基础技术研究。该实验室此前已获得20亿美元种子轮融资,并计划在未来几个月推出首款产品。这项技术突破标志着AI行业正从追求模型规模转向追求应用质量的发展新阶段。随着确定性输出技术的推广应用,AI系统的可靠性和实用性有望获得显著提升。

官方研究报告:https://thinkingmachines.ai/blog/defeating-nondeterminism-in-llm-inference/